+

+ +

+ +

+

+## المحتويات

+

+ينقسم التوثيق إلى خمسة أقسام:

+

+- **ابدأ** تقدم جولة سريعة في المكتبة وتعليمات التثبيت للبدء.

+- **الدروس التعليمية** هي مكان رائع للبدء إذا كنت مبتدئًا. سيساعدك هذا القسم على اكتساب المهارات الأساسية التي تحتاجها للبدء في استخدام المكتبة.

+- **أدلة كيفية الاستخدام** تُظهر لك كيفية تحقيق هدف محدد، مثل ضبط نموذج مسبق التدريب لنمذجة اللغة أو كيفية كتابة ومشاركة نموذج مخصص.

+- **الأدلة المفاهيمية** تقدم مناقشة وتفسيرًا أكثر للأفكار والمفاهيم الأساسية وراء النماذج والمهام وفلسفة التصميم في 🤗 Transformers.

+- **واجهة برمجة التطبيقات (API)** تصف جميع الفئات والوظائف:

+

+ - **الفئات الرئيسية** تشرح الفئات الأكثر أهمية مثل التكوين والنمذجة والتحليل النصي وخط الأنابيب.

+ - **النماذج** تشرح الفئات والوظائف المتعلقة بكل نموذج يتم تنفيذه في المكتبة.

+ - **المساعدون الداخليون** يشرحون فئات ووظائف المساعدة التي يتم استخدامها داخليًا.

+

+

+## النماذج والأطر المدعومة

+

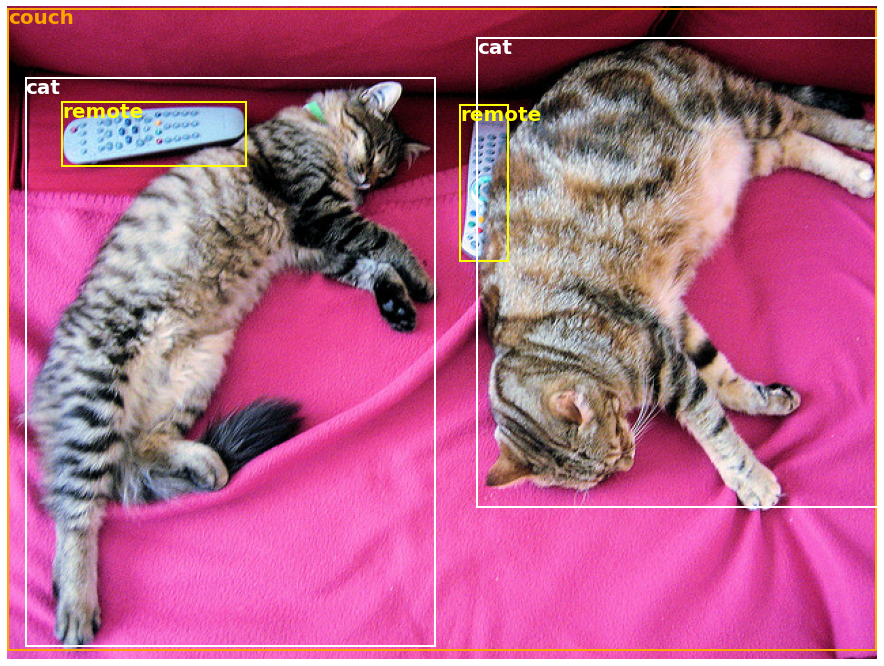

+يمثل الجدول أدناه الدعم الحالي في المكتبة لكل من هذه النماذج، وما إذا كان لديها محلل نحوي Python (يُسمى "بطيء"). محلل نحوي "سريع" مدعوم بمكتبة 🤗 Tokenizers، وما إذا كان لديها دعم في Jax (عبر Flax) و/أو PyTorch و/أو TensorFlow.

+

+

+# Hugging Face Hub: قائمة النماذج

+

+آخر تحديث: 06/08/2024

+

+| النموذج | دعم PyTorch | دعم TensorFlow | دعم Flax |

+| :----: | :---------: | :------------: | :-------: |

+| [ALBERT](model_doc/albert) | ✅ | ✅ | ✅ |

+| [ALIGN](model_doc/align) | ✅ | ❌ | ❌ |

+| [AltCLIP](model_doc/altclip) | ✅ | ❌ | ❌ |

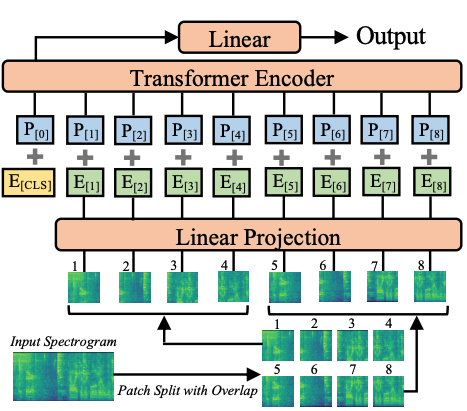

+| [Audio Spectrogram Transformer](model_doc/audio-spectrogram-transformer) | ✅ | ❌ | ❌ |

+| [Autoformer](model_doc/autoformer) | ✅ | ❌ | ❌ |

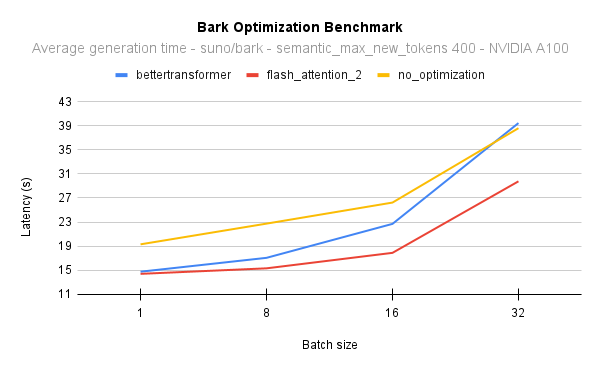

+| [Bark](model_doc/bark) | ✅ | ❌ | ❌ |

+| [BART](model_doc/bart) | ✅ | ✅ | ✅ |

+| [BARThez](model_doc/barthez) | ✅ | ✅ | ✅ |

+| [BARTpho](model_doc/bartpho) | ✅ | ✅ | ✅ |

+| [BEiT](model_doc/beit) | ✅ | ❌ | ✅ |

+| [BERT](model_doc/bert) | ✅ | ✅ | ✅ |

+| [Bert Generation](model_doc/bert-generation) | ✅ | ❌ | ❌ |

+| [BertJapanese](model_doc/bert-japanese) | ✅ | ✅ | ✅ |

+| [BERTweet](model_doc/bertweet) | ✅ | ✅ | ✅ |

+| [BigBird](model_doc/big_bird) | ✅ | ❌ | ✅ |

+| [BigBird-Pegasus](model_doc/bigbird_pegasus) | ✅ | ❌ | ❌ |

+| [BioGpt](model_doc/biogpt) | ✅ | ❌ | ❌ |

+| [BiT](model_doc/bit) | ✅ | ❌ | ❌ |

+| [Blenderbot](model_doc/blenderbot) | ✅ | ✅ | ✅ |

+| [BlenderbotSmall](model_doc/blenderbot-small) | ✅ | ✅ | ✅ |

+| [BLIP](model_doc/blip) | ✅ | ✅ | ❌ |

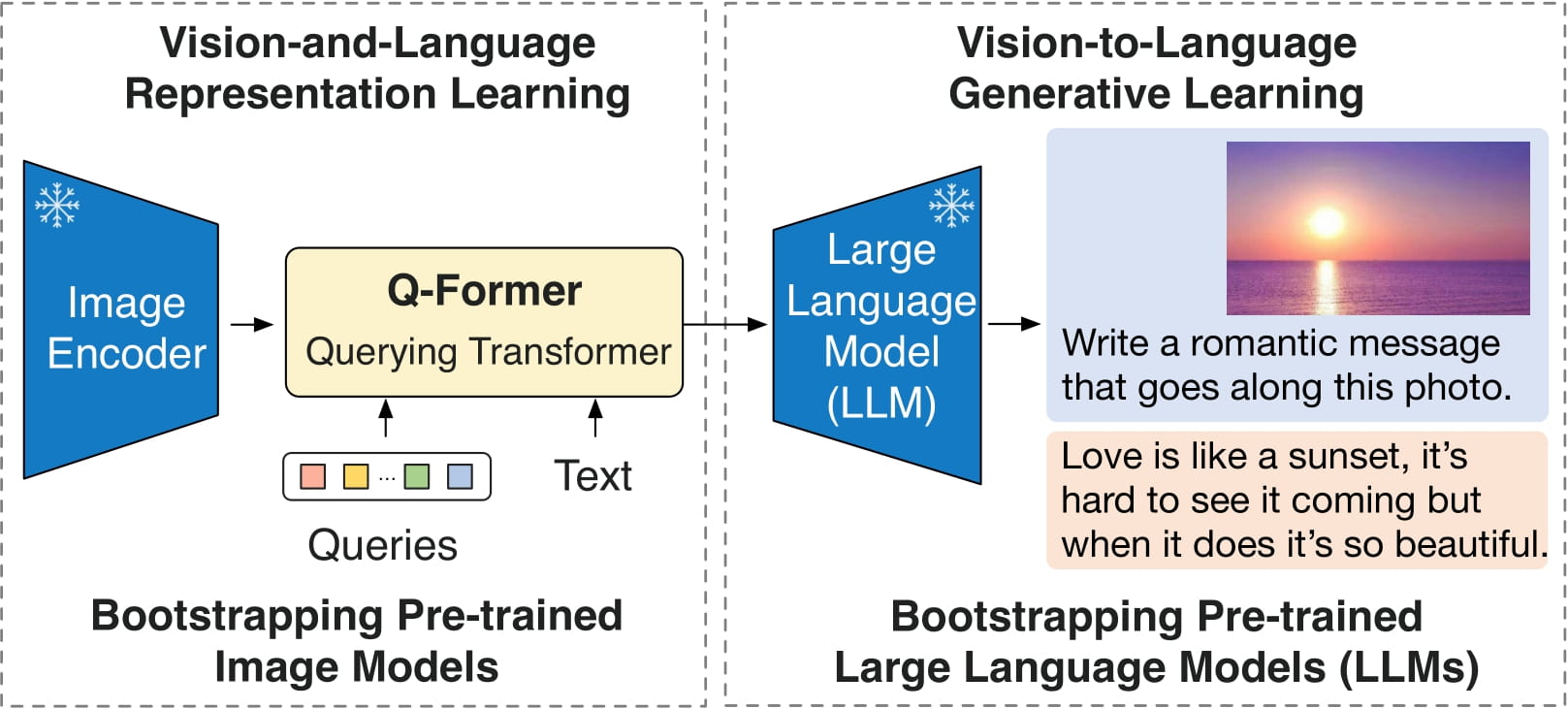

+| [BLIP-2](model_doc/blip-2) | ✅ | ❌ | ❌ |

+| [BLOOM](model_doc/bloom) | ✅ | ❌ | ✅ |

+| [BORT](model_doc/bort) | ✅ | ✅ | ✅ |

+| [BridgeTower](model_doc/bridgetower) | ✅ | ❌ | ❌ |

+| [BROS](model_doc/bros) | ✅ | ❌ | ❌ |

+| [ByT5](model_doc/byt5) | ✅ | ✅ | ✅ |

+| [CamemBERT](model_doc/camembert) | ✅ | ✅ | ❌ |

+| [CANINE](model_doc/canine) | ✅ | ❌ | ❌ |

+# النماذج Models

+

+| النموذج/المهمة | التصنيف Classification | استخراج المعلومات Information Extraction | توليد Generation |

+| :-----: | :----: | :----: | :----: |

+| [CANINE](model_doc/canine) | ✅ | ❌ | ❌ |

+| [Chameleon](model_doc/chameleon) | ✅ | ❌ | ❌ |

+| [Chinese-CLIP](model_doc/chinese_clip) | ✅ | ❌ | ❌ |

+| [CLAP](model_doc/clap) | ✅ | ❌ | ❌ |

+| [CLIP](model_doc/clip) | ✅ | ✅ | ✅ |

+| [CLIPSeg](model_doc/clipseg) | ✅ | ❌ | ❌ |

+| [CLVP](model_doc/clvp) | ✅ | ❌ | ❌ |

+| [CodeGen](model_doc/codegen) | ✅ | ❌ | ❌ |

+| [CodeLlama](model_doc/code_llama) | ✅ | ❌ | ✅ |

+| [Cohere](model_doc/cohere) | ✅ | ❌ | ❌ |

+| [Conditional DETR](model_doc/conditional_detr) | ✅ | ❌ | ❌ |

+| [ConvBERT](model_doc/convbert) | ✅ | ✅ | ❌ |

+| [ConvNeXT](model_doc/convnext) | ✅ | ✅ | ❌ |

+| [ConvNeXTV2](model_doc/convnextv2) | ✅ | ✅ | ❌ |

+| [CPM](model_doc/cpm) | ✅ | ✅ | ✅ |

+| [CPM-Ant](model_doc/cpmant) | ✅ | ❌ | ❌ |

+| [CTRL](model_doc/ctrl) | ✅ | ✅ | ❌ |

+| [CvT](model_doc/cvt) | ✅ | ✅ | ❌ |

+| [Data2VecAudio](model_doc/data2vec) | ✅ | ❌ | ❌ |

+| [Data2VecText](model_doc/data2vec) | ✅ | ❌ | ❌ |

+| [Data2VecVision](model_doc/data2vec) | ✅ | ✅ | ❌ |

+| [DBRX](model_doc/dbrx) | ✅ | ❌ | ❌ |

+| [DeBERTa](model_doc/deberta) | ✅ | ✅ | ❌ |

+| [DeBERTa-v2](model_doc/deberta-v2) | ✅ | ✅ | ❌ |

+| [Decision Transformer](model_doc/decision_transformer) | ✅ | ❌ | ❌ |

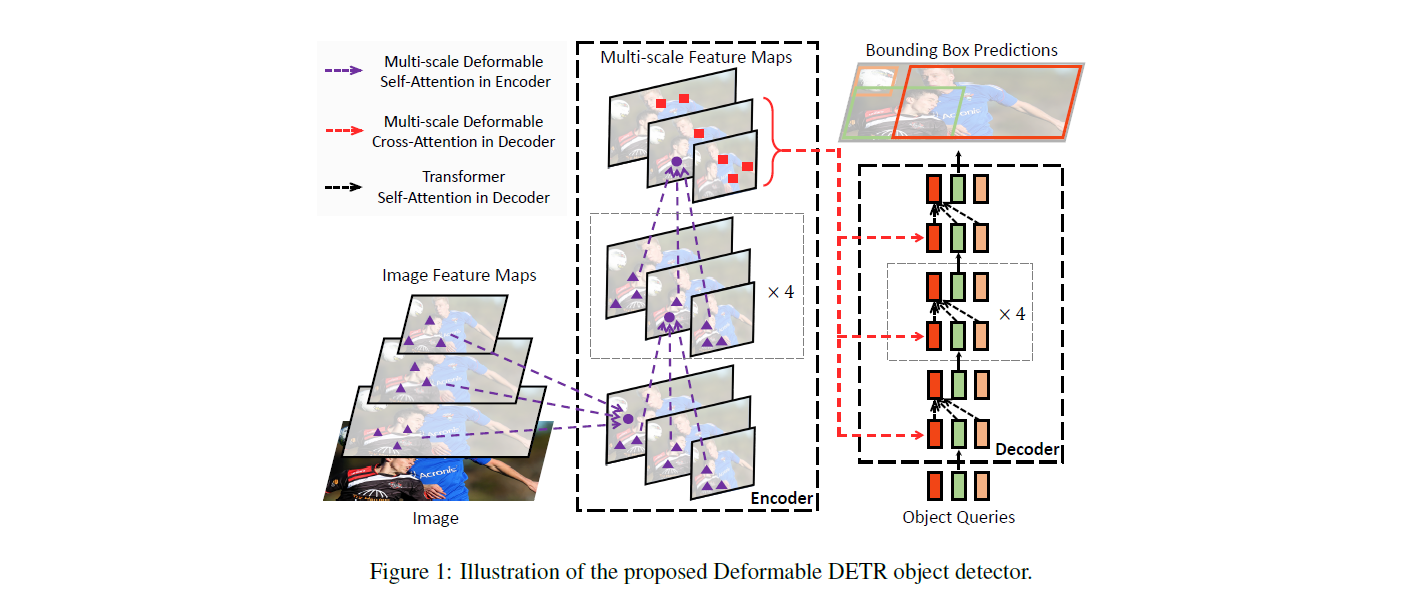

+| [Deformable DETR](model_doc/deformable_detr) | ✅ | ❌ | ❌ |

+| [DeiT](model_doc/deit) | ✅ | ✅ | ❌ |

+| [DePlot](model_doc/deplot) | ✅ | ❌ | ❌ |

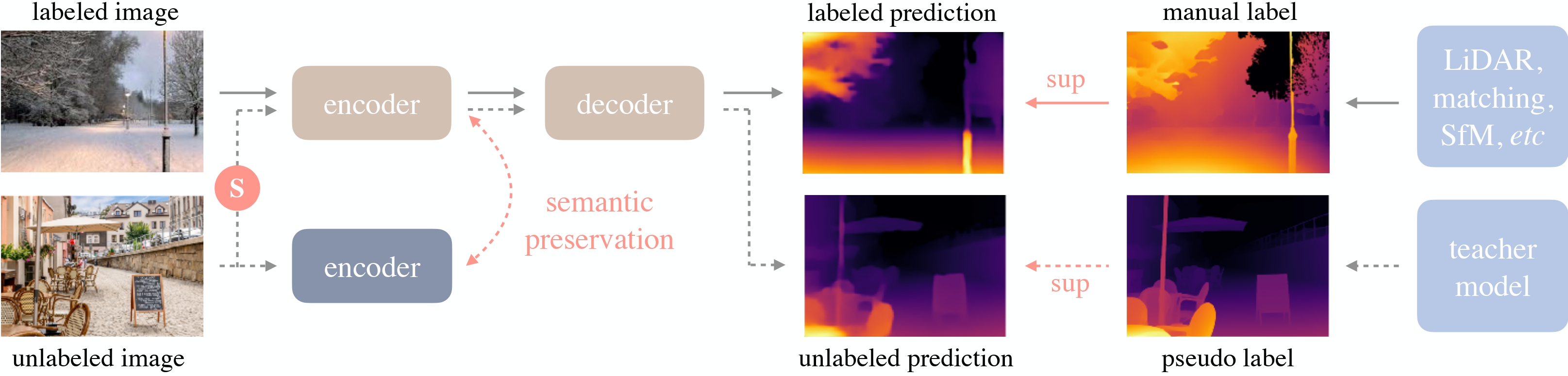

+| [Depth Anything](model_doc/depth_anything) | ✅ | ❌ | ❌ |

+| [DETA](model_doc/deta) | ✅ | ❌ | ❌ |

+| [DETR](model_doc/detr) | | | |

+# قائمة النماذج

+

+| الاسم باللغة الإنجليزية | الوصف باللغة الإنجليزية | الوصف باللغة العربية |

+| :--------------------- | :---------------------- | :------------------- |

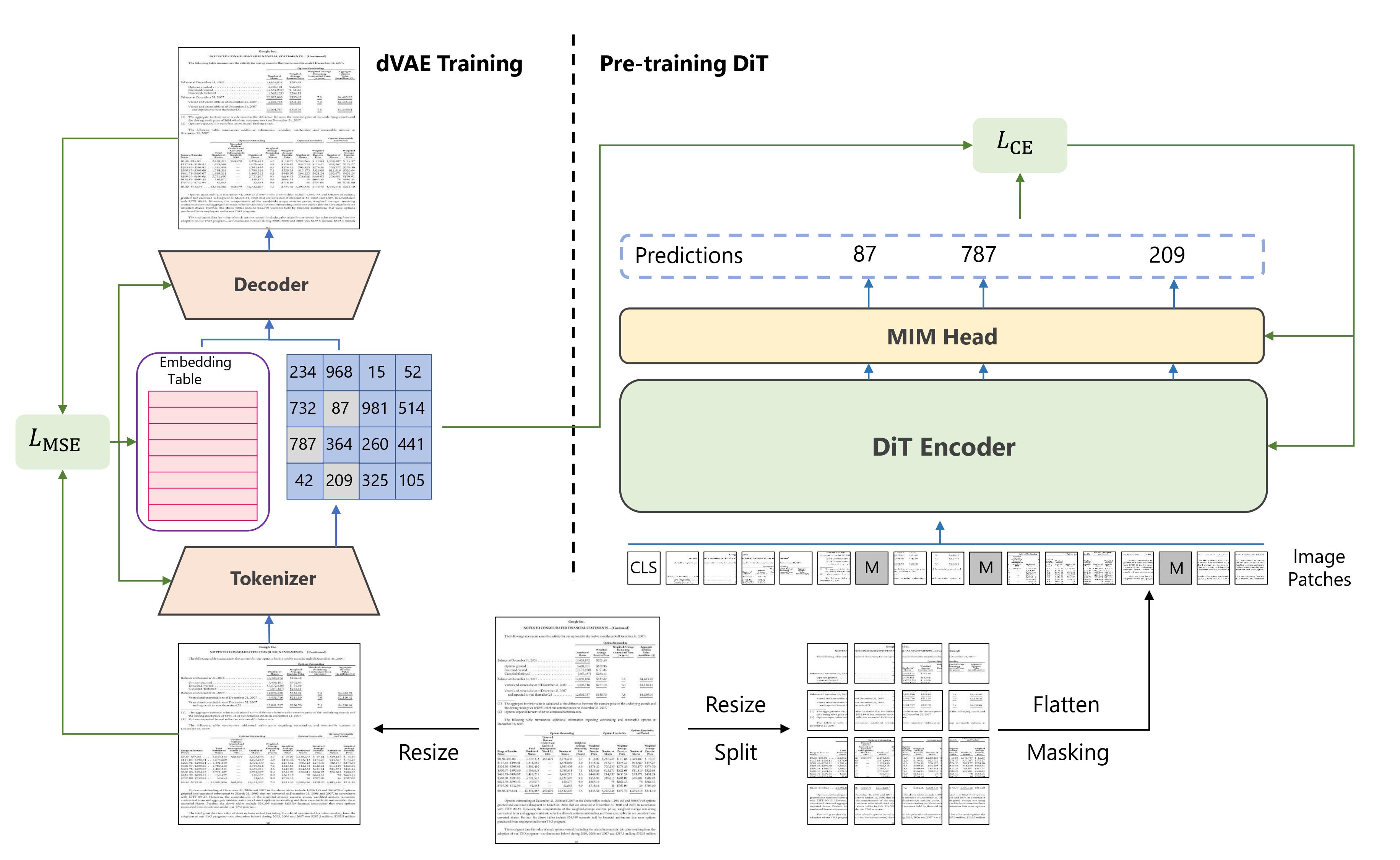

+| [DiT](model_doc/dit) | ✅ | |

+| [DonutSwin](model_doc/donut) | ✅ | |

+| [DPT](model_doc/dpt) | ✅ | |

+| [EfficientFormer](model_doc/efficientformer) | ✅ | |

+| [EnCodec](model_doc/encodec) | ✅ | |

+| [ErnieM](model_doc/ernie_m) | ✅ | |

+| [FNet](model_doc/fnet) | ✅ | |

+| [FocalNet](model_doc/focalnet) | ✅ | |

+| [Fuyu](model_doc/fuyu) | ✅ | |

+| [Gemma2](model_doc/gemma2) | ✅ | |

+| [GIT](model_doc/git) | ✅ | |

+# النماذج المدعومة حالياً

+

+| النموذج | النص | الصور | الصوت |

+|-------------|--------|---------|-------|

+| [GIT](model_doc/git) | ✅ | ❌ | ❌ |

+| [GLPN](model_doc/glpn) | ✅ | ❌ | ❌ |

+| [GPT Neo](model_doc/gpt_neo) | ✅ | ❌ | ✅ |

+| [GPT NeoX](model_doc/gpt_neox) | ✅ | ❌ | ❌ |

+| [GPT NeoX Japanese](model_doc/gpt_neox_japanese) | ✅ | ❌ | ❌ |

+| [GPT-J](model_doc/gptj) | ✅ | ✅ | ✅ |

+| [GPT-Sw3](model_doc/gpt-sw3) | ✅ | ✅ | ✅ |

+| [GPTBigCode](model_doc/gpt_bigcode) | ✅ | ❌ | ❌ |

+| [GPTSAN-japanese](model_doc/gptsan-japanese) | ✅ | ❌ | ❌ |

+| [Graphormer](model_doc/graphormer) | ✅ | ❌ | ❌ |

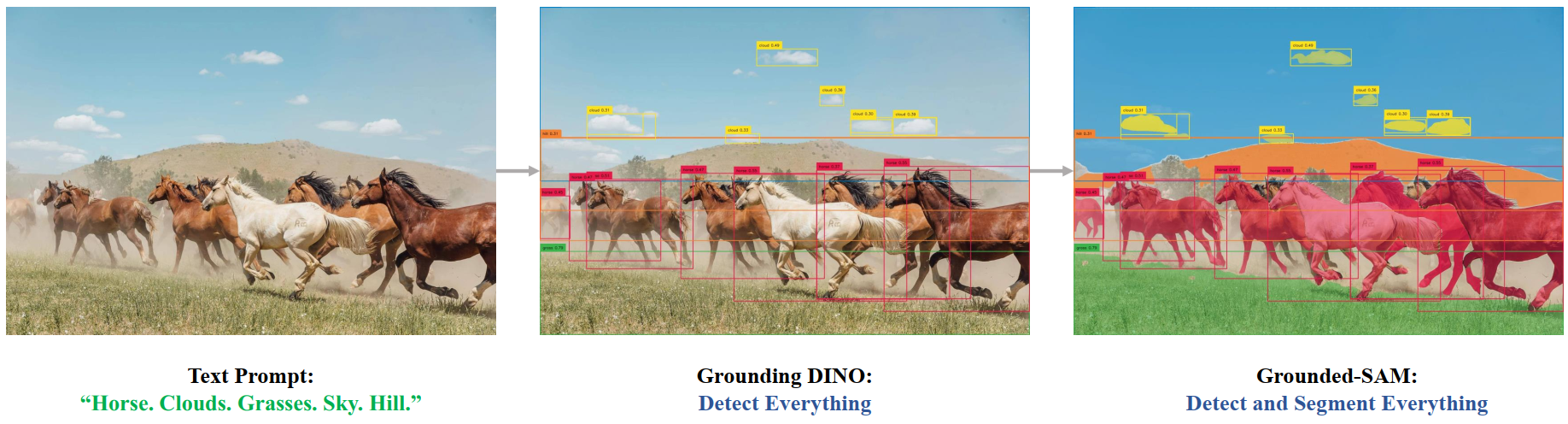

+| [Grounding DINO](model_doc/grounding-dino) | ✅ | ❌ | ❌ |

+| [GroupViT](model_doc/groupvit) | ✅ | ✅ | ❌ |

+| [HerBERT](model_doc/herbert) | ✅ | ✅ | ✅ |

+| [Hiera](model_doc/hiera) | ✅ | ❌ | ❌ |

+| [Hubert](model_doc/hubert) | ✅ | ✅ | ❌ |

+| [I-BERT](model_doc/ibert) | ✅ | ❌ | ❌ |

+| [IDEFICS](model_doc/idefics) | ✅ | ✅ | ❌ |

+| [Idefics2](model_doc/idefics2) | ✅ | ❌ | ❌ |

+| [ImageGPT](model_doc/imagegpt) | ✅ | ❌ | ❌ |

+| [Informer](model_doc/informer) | ✅ | ❌ | ❌ |

+| [InstructBLIP](model_doc/instructblip) | ✅ | ❌ | ❌ |

+| [InstructBlipVideo](model_doc/instructblipvideo) | ✅ | ❌ | ❌ |

+| [Jamba](model_doc/jamba) | ✅ | ❌ | ❌ |

+| [JetMoe](model_doc/jetmoe) | ✅ | ❌ | ❌ |

+| [Jukebox](model_doc/jukebox) | ✅ | ❌ | ❌ |

+| [KOSMOS-2](model_doc/kosmos-2) | ✅ | ❌ | ❌ |

+| [LayoutLM](model_doc/layoutlm) | ✅ | ✅ | ❌ |

+| [LayoutLMv2](model_doc/layoutlmv2) | ✅ | ❌ | ❌ |

+| [LayoutLMv3](model_doc/layoutlmv3) | ✅ | ✅ | ❌ |

+| [LayoutXLM](model_doc/layoutxlm) | ✅ | ❌ | ❌ |

+| [LED](model_doc/led) | ✅ | ✅ | ❌ |

+# Hugging Face Models

+

+مرحباً! هذه قائمة بالنماذج المتاحة في Hugging Face Hub. تم تحديثها مؤخراً لتشمل أحدث النماذج وأكثرها شعبية.

+

+| الاسم | النص | الصورة | الصوت |

+| --- | --- | --- | --- |

+| [LED](model_doc/led) | ✅ | ✅ | ❌ |

+| [LeViT](model_doc/levit) | ✅ | ❌ | ❌ |

+| [LiLT](model_doc/lilt) | ✅ | ❌ | ❌ |

+| [LLaMA](model_doc/llama) | ✅ | ❌ | ✅ |

+| [Llama2](model_doc/llama2) | ✅ | ❌ | ✅ |

+| [Llama3](model_doc/llama3) | ✅ | ❌ | ✅ |

+| [LLaVa](model_doc/llava) | ✅ | ❌ | ❌ |

+| [LLaVA-NeXT](model_doc/llava_next) | ✅ | ❌ | ❌ |

+| [LLaVa-NeXT-Video](model_doc/llava-next-video) | ✅ | ❌ | ❌ |

+| [Longformer](model_doc/longformer) | ✅ | ✅ | ❌ |

+| [LongT5](model_doc/longt5) | ✅ | ❌ | ✅ |

+| [LUKE](model_doc/luke) | ✅ | ❌ | ❌ |

+| [LXMERT](model_doc/lxmert) | ✅ | ✅ | ❌ |

+| [M-CTC-T](model_doc/mctct) | ✅ | ❌ | ❌ |

+| [M2M100](model_doc/m2m_100) | ✅ | ❌ | ❌ |

+| [MADLAD-400](model_doc/madlad-400) | ✅ | ✅ | ✅ |

+| [Mamba](model_doc/mamba) | ✅ | ❌ | ❌ |

+| [Marian](model_doc/marian) | ✅ | ✅ | ✅ |

+| [MarkupLM](model_doc/markuplm) | ✅ | ❌ | ❌ |

+| [Mask2Former](model_doc/mask2former) | ✅ | ❌ | ❌ |

+| [MaskFormer](model_doc/maskformer) | ✅ | ❌ | ❌ |

+| [MatCha](model_doc/matcha) | ✅ | ❌ | ❌ |

+| [mBART](model_doc/mbart) | ✅ | ✅ | ✅ |

+| [mBART-50](model_doc/mbart50) | ✅ | ✅ | ✅ |

+| [MEGA](model_doc/mega) | ✅ | ❌ | ❌ |

+| [Megatron-BERT](model_doc/megatron-bert) | ✅ | ❌ | ❌ |

+| [Megatron-GPT2](model_doc/megatron_gpt2) | ✅ | ✅ | ✅ |

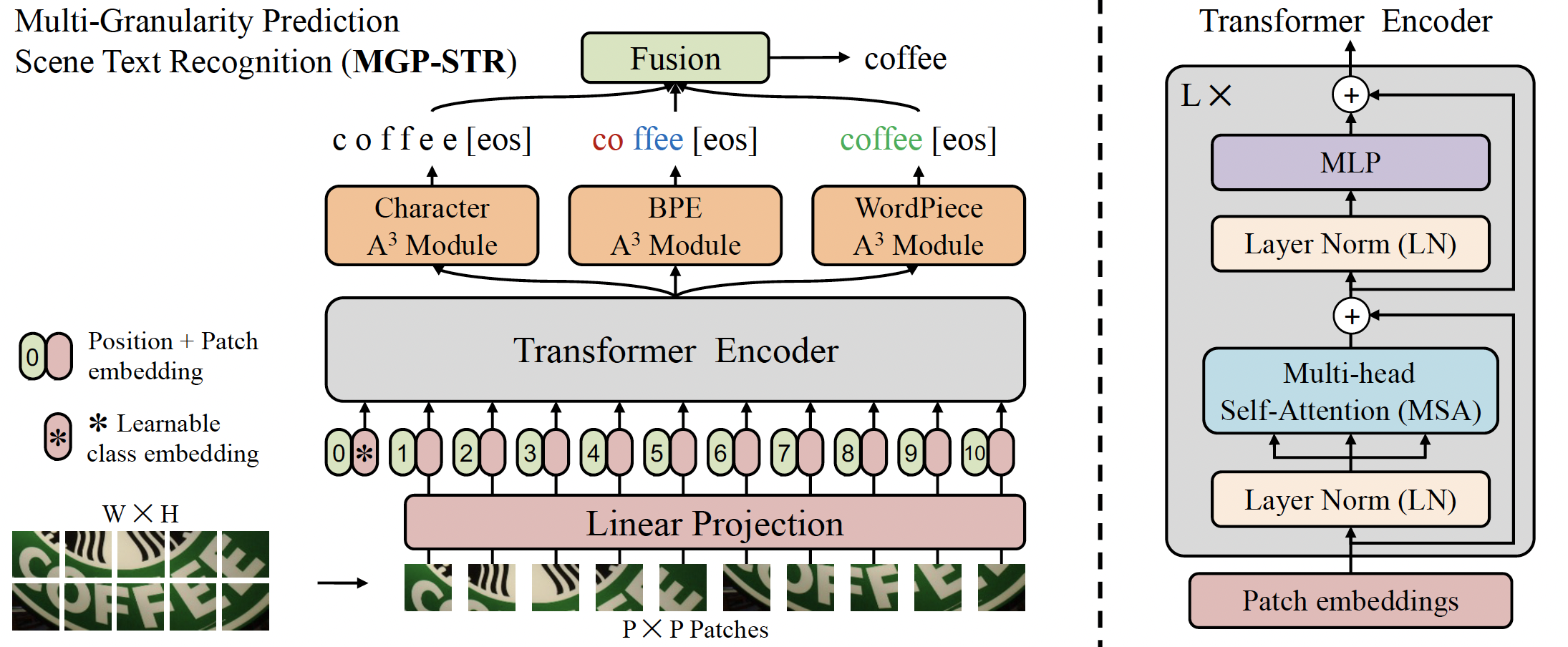

+| [MGP-STR](model_doc/mgp-str) | ✅ | ❌ | ❌ |

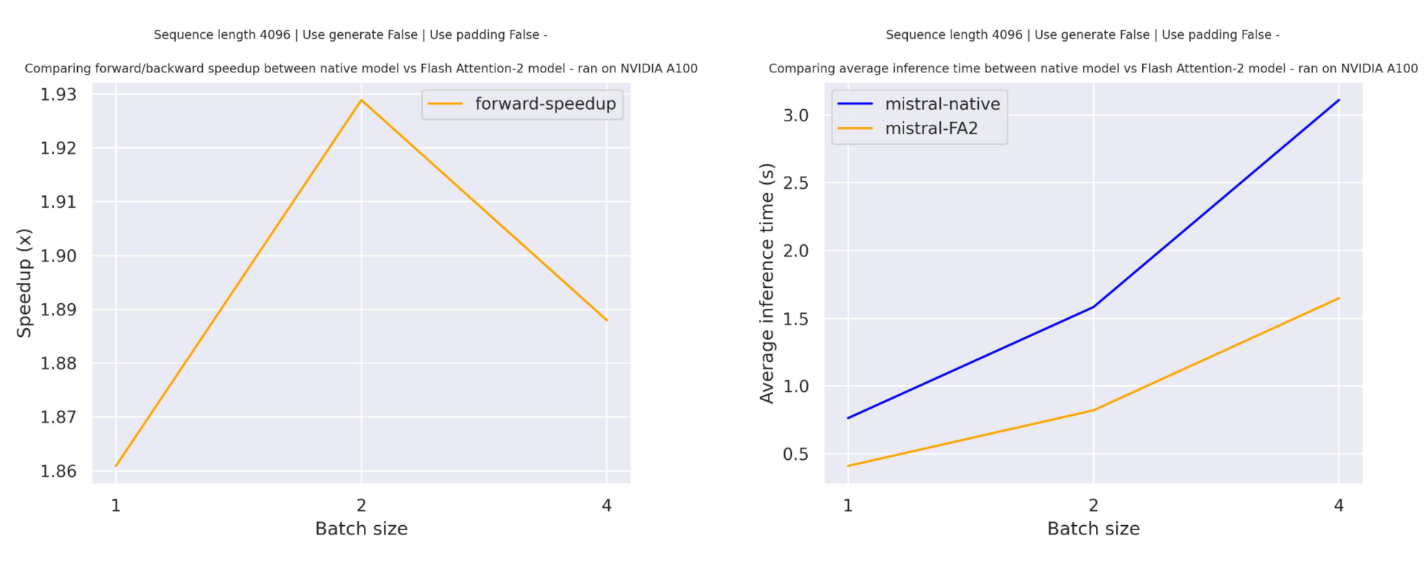

+| [Mistral](model_doc/mistral) | ✅ | ✅ | ✅ |

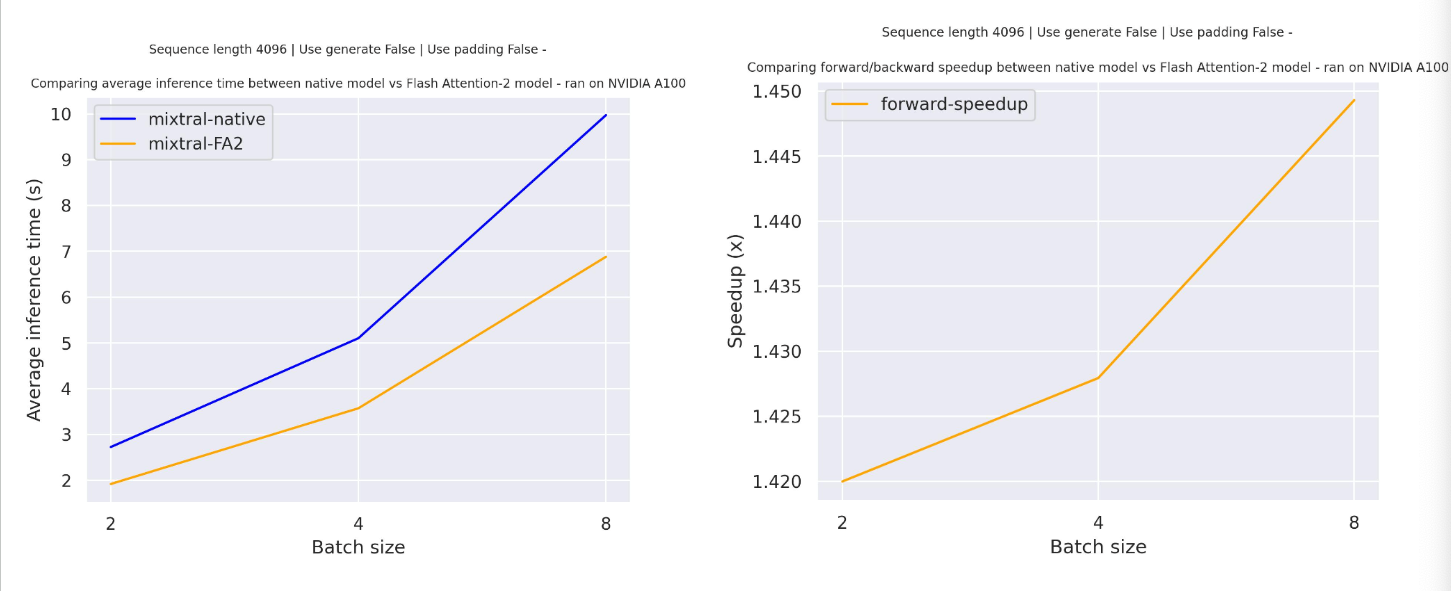

+| [Mixtral](model_doc/mixtral) | ✅ | ❌ | ❌ |

+| [mLUKE](model_doc/mluke) | ✅ | ❌ | ❌ |

+# Hugging Face Models

+

+نموذج Hugging Face هو تمثيل لخوارزمية تعلم الآلة التي يمكن تدريبها على بيانات محددة لأداء مهام مختلفة مثل تصنيف النصوص أو توليد الصور. توفر Hugging Face مجموعة واسعة من النماذج التي يمكن استخدامها مباشرة أو تخصيصها لمهمة محددة.

+

+## نظرة عامة على النماذج

+

+| الاسم | النص | الصورة/الكائن | الصوت |

+| ---------------------------------------- | ----------- | ------------- | --------- |

+| [mLUKE](model_doc/mluke) | ✅ | ❌ | ❌ |

+| [MMS](model_doc/mms) | ✅ | ✅ | ✅ |

+| [MobileBERT](model_doc/mobilebert) | ✅ | ✅ | ❌ |

+| [MobileNetV1](model_doc/mobilenet_v1) | ✅ | ❌ | ❌ |

+| [MobileNetV2](model_doc/mobilenet_v2) | ✅ | ❌ | ❌ |

+| [MobileViT](model_doc/mobilevit) | ✅ | ✅ | ❌ |

+| [MobileViTV2](model_doc/mobilevitv2) | ✅ | ❌ | ❌ |

+| [MPNet](model_doc/mpnet) | ✅ | ✅ | ❌ |

+| [MPT](model_doc/mpt) | ✅ | ❌ | ❌ |

+| [MRA](model_doc/mra) | ✅ | ❌ | ❌ |

+| [MT5](model_doc/mt5) | ✅ | ✅ | ✅ |

+| [MusicGen](model_doc/musicgen) | ✅ | ❌ | ❌ |

+| [MusicGen Melody](model_doc/musicgen_melody) | ✅ | ❌ | ❌ |

+| [MVP](model_doc/mvp) | ✅ | ❌ | ❌ |

+| [NAT](model_doc/nat) | ✅ | ❌ | ❌ |

+| [Nezha](model_doc/nezha) | ✅ | ❌ | ❌ |

+| [NLLB](model_doc/nllb) | ✅ | ❌ | ❌ |

+| [NLLB-MOE](model_doc/nllb-moe) | ✅ | ❌ | ❌ |

+| [Nougat](model_doc/nougat) | ✅ | ✅ | ✅ |

+| [Nyströmformer](model_doc/nystromformer) | ✅ | ❌ | ❌ |

+| [OLMo](model_doc/olmo) | ✅ | ❌ | ❌ |

+| [OneFormer](model_doc/oneformer) | ✅ | ❌ | ❌ |

+| [OpenAI GPT](model_doc/openai-gpt) | ✅ | ✅ | ❌ |

+| [OpenAI GPT-2](model_doc/gpt2) | ✅ | ✅ | ✅ |

+| [OpenLlama](model_doc/open-llama) | ✅ | ❌ | ❌ |

+| [OPT](model_doc/opt) | ✅ | ✅ | ✅ |

+| [OWL-ViT](model_doc/owlvit) | ✅ | ❌ | ❌ |

+| [OWLv2](model_doc/owlv2) | ✅ | ❌ | ❌ |

+| [PaliGemma](model_doc/paligemma) | ✅ | ❌ | ❌ |

+| [PatchTSMixer](model_doc/patchtsmixer) | ✅ | ❌ | ❌ |

+| [PatchTST](model_doc/patchtst) | ✅ | ❌ | ❌ |

+# النماذج المدعومة

+

+| الاسم | التصنيف | التوليد | استخراج المعلومات |

+| --- | --- | --- | --- |

+| [PatchTST](model_doc/patchtst) | ✅ | ❌ | ❌ |

+| [Pegasus](model_doc/pegasus) | ✅ | ✅ | ✅ |

+| [PEGASUS-X](model_doc/pegasus_x) | ✅ | ❌ | ❌ |

+| [Perceiver](model_doc/perceiver) | ✅ | ❌ | ❌ |

+| [Persimmon](model_doc/persimmon) | ✅ | ❌ | ❌ |

+| [Phi](model_doc/phi) | ✅ | ❌ | ❌ |

+| [Phi3](model_doc/phi3) | ✅ | ❌ | ❌ |

+| [PhoBERT](model_doc/phobert) | ✅ | ✅ | ✅ |

+| [Pix2Struct](model_doc/pix2struct) | ✅ | ❌ | ❌ |

+| [PLBart](model_doc/plbart) | ✅ | ❌ | ❌ |

+| [PoolFormer](model_doc/poolformer) | ✅ | ❌ | ❌ |

+| [Pop2Piano](model_doc/pop2piano) | ✅ | ❌ | ❌ |

+| [ProphetNet](model_doc/prophetnet) | ✅ | ❌ | ❌ |

+| [PVT](model_doc/pvt) | ✅ | ❌ | ❌ |

+| [PVTv2](model_doc/pvt_v2) | ✅ | ❌ | ❌ |

+| [QDQBert](model_doc/qdqbert) | ✅ | ❌ | ❌ |

+| [Qwen2](model_doc/qwen2) | ✅ | ❌ | ❌ |

+| [Qwen2MoE](model_doc/qwen2_moe) | ✅ | ❌ | ❌ |

+| [RAG](model_doc/rag) | ✅ | ✅ | ❌ |

+| [REALM](model_doc/realm) | ✅ | ❌ | ❌ |

+| [RecurrentGemma](model_doc/recurrent_gemma) | ✅ | ❌ | ❌ |

+| [Reformer](model_doc/reformer) | ✅ | ❌ | ❌ |

+| [RegNet](model_doc/regnet) | ✅ | ✅ | ✅ |

+| [RemBERT](model_doc/rembert) | ✅ | ✅ | ❌ |

+| [ResNet](model_doc/resnet) | ✅ | ✅ | ✅ |

+| [RetriBERT](model_doc/retribert) | ✅ | ❌ | ❌ |

+| [RoBERTa](model_doc/roberta) | ✅ | ✅ | ✅ |

+| [RoBERTa-PreLayerNorm](model_doc/roberta-prelayernorm) | ✅ | ✅ | ✅ |

+| [RoCBert](model_doc/roc_bert) | ✅ | ❌ | ❌ |

+| [RoFormer](model_doc/roformer) | ✅ | ✅ | ✅ |

+| [RT-DETR](model_doc/rt_detr) | ✅ | ❌ | ❌ |

+# النماذج المدعومة

+

+| الاسم | التصنيف | الكشف | التتبع |

+| ---------------------------------------------------------------------------------------------------------------------------------------------------- | :-----: | :-----: | :------: |

+| [RT-DETR](model_doc/rt_detr) | ✅ | ❌ | ❌ |

+| [RT-DETR-ResNet](model_doc/rt_detr_resnet) | ✅ | ❌ | ❌ |

+| [RWKV](model_doc/rwkv) | ✅ | ❌ | ❌ |

+| [SAM](model_doc/sam) | ✅ | ✅ | ❌ |

+| [SeamlessM4T](model_doc/seamless_m4t) | ✅ | ❌ | ❌ |

+| [SeamlessM4Tv2](model_doc/seamless_m4t_v2) | ✅ | ❌ | ❌ |

+| [SegFormer](model_doc/segformer) | ✅ | ✅ | ❌ |

+| [SegGPT](model_doc/seggpt) | ✅ | ❌ | ❌ |

+| [SEW](model_doc/sew) | ✅ | ❌ | ❌ |

+| [SEW-D](model_doc/sew-d) | ✅ | ❌ | ❌ |

+| [SigLIP](model_doc/siglip) | ✅ | ❌ | ❌ |

+| [Speech Encoder decoder](model_doc/speech-encoder-decoder) | ✅ | ❌ | ✅ |

+| [Speech2Text](model_doc/speech_to_text) | ✅ | ✅ | ❌ |

+| [SpeechT5](model_doc/speecht5) | ✅ | ❌ | ❌ |

+| [Splinter](model_doc/splinter) | ✅ | ❌ | ❌ |

+| [SqueezeBERT](model_doc/squeezebert) | ✅ | ❌ | ❌ |

+| [StableLm](model_doc/stablelm) | ✅ | ❌ | ❌ |

+| [Starcoder2](model_doc/starcoder2) | ✅ | ❌ | ❌ |

+| [SuperPoint](model_doc/superpoint) | ✅ | ❌ | ❌ |

+| [SwiftFormer](model_doc/swiftformer) | ✅ | ✅ | ❌ |

+| [Swin Transformer](model_doc/swin) | ✅ | ✅ | ❌ |

+| [Swin Transformer V2](model_doc/swinv2) | ✅ | ❌ | ❌ |

+| [Swin2SR](model_doc/swin2sr) | ✅ | ❌ | ❌ |

+| [SwitchTransformers](model_doc/switch_transformers) | ✅ | ❌ | ❌ |

+| [T5](model_doc/t5) | ✅ | ✅ | ✅ |

+| [T5v1.1](model_doc/t5v1.1) | ✅ | ✅ | ✅ |

+| [Table Transformer](model_doc/table-transformer) | ✅ | ❌ | ❌ |

+| [TAPAS](model_doc/tapas) | ✅ | ✅ | ❌ |

+| [TAPEX](model_doc/tapex) | ✅ | ✅ | ✅ |

+| [Time Series Transformer](model_doc/time_series_transformer) | ✅ | ❌ | ❌ |

+| [TimeSformer](model_doc/timesformer) | ✅ | ❌ | ❌ |

+# قائمة النماذج المدعومة

+

+| الاسم | التصنيف | النص | الصورة |

+| -------------------------------------- | ------ | -------- | --------- |

+| [UL2](model_doc/ul2) | ✅ | ✅ | ✅ |

+| [Wav2Vec2](model_doc/wav2vec2) | ✅ | ✅ | ✅ |

+| [TimeSformer](model_doc/timesformer) | ✅ | ❌ | ❌ |

+| [Trajectory Transformer](model_doc/trajectory_transformer) | ✅ | ❌ | ❌ |

+| [Transformer-XL](model_doc/transfo-xl) | ✅ | ✅ | ❌ |

+| ... | ... | ... | ... |

+

+# تفاصيل النموذج

+

+يرجى الرجوع إلى [README.md](README.md#model-zoo) للحصول على تفاصيل حول كيفية إضافة نموذج جديد.

+

+# النماذج المدعومة

+

+## النص

+

+| الاسم | التصنيف | النص-النص | النص-الصورة | النص-الفيديو |

+| -------------------------------------------- | ------ | --------- | ----------- | ------------ |

+| [TimeSformer](model_doc/timesformer) | ✅ | ❌ | ❌ | ❌ |

+| [Trajectory Transformer](model_doc/trajectory_transformer) | ✅ | ❌ | ❌ | ❌ |

+| [Transformer-XL](model_doc/transfo-xl) | ✅ | ✅ | ❌ | ❌ |

+| ... | ... | ... | ... | ... |

+

+## الصورة

+

+| الاسم | التصنيف | النص-الصورة | الصورة-الصورة |

+| ---------------------------------------- | ------ | ----------- | ------------- |

+| [UL2](model_doc/ul2) | ✅ | ✅ | ✅ |

+| [ViT](model_doc/vit) | ✅ | ✅ | ✅ |

+| [ViT Hybrid](model_doc/vit_hybrid) | ✅ | ❌ | ❌ |

+| [VitDet](model_doc/vitdet) | ✅ | ❌ | ❌ |

+| [ViTMAE](model_doc/vit_mae) | ✅ | ✅ | ❌ |

+| ... | ... | ... | ... |

+

+## الفيديو

+

+| الاسم | التصنيف | النص-الفيديو | الفيديو-الفيديو |

+| ---------------------------------------- | ------ | ------------ | -------------- |

+| [VideoLlava](model_doc/video_llava) | ✅ | ❌ | ❌ |

+| [VideoMAE](model_doc/videomae) | ✅ | ❌ | ❌ |

+| [ViLT](model_doc/vilt) | ✅ | ❌ | ❌ |

+| [VipLlava](model_doc/vipllava) | ✅ | ❌ | ❌ |

+| ... | ... | ... | ... |

+# النماذج المدعومة

+

+| الاسم | الصوت | النص | الصورة |

+| ------------------------------------------------------------------- | ----- | ---- | ------ |

+| [Wav2Vec2-BERT](model_doc/wav2vec2-bert) | ✅ | ❌ | ❌ |

+| [Wav2Vec2-Conformer](model_doc/wav2vec2-conformer) | ✅ | ❌ | ❌ |

+| [Wav2Vec2Phoneme](model_doc/wav2vec2_phoneme) | ✅ | ✅ | ✅ |

+| [WavLM](model_doc/wavlm) | ✅ | ❌ | ❌ |

+| [Whisper](model_doc/whisper) | ✅ | ✅ | ✅ |

+| [X-CLIP](model_doc/xclip) | ✅ | ❌ | ❌ |

+| [X-MOD](model_doc/xmod) | ✅ | ❌ | ❌ |

+| [XGLM](model_doc/xglm) | ✅ | ✅ | ✅ |

+| [XLM](model_doc/xlm) | ✅ | ✅ | ❌ |

+| [XLM-ProphetNet](model_doc/xlm-prophetnet) | ✅ | ❌ | ❌ |

+| [XLM-RoBERTa](model_doc/xlm-roberta) | ✅ | ✅ | ✅ |

+| [XLM-RoBERTa-XL](model_doc/xlm-roberta-xl) | ✅ | ❌ | ❌ |

+| [XLM-V](model_doc/xlm-v) | ✅ | ✅ | ✅ |

+| [XLNet](model_doc/xlnet) | ✅ | ✅ | ❌ |

+| [XLS-R](model_doc/xls_r) | ✅ | ✅ | ✅ |

+| [XLSR-Wav2Vec2](model_doc/xlsr_wav2vec2) | ✅ | ✅ | ✅ |

+| [YOLOS](model_doc/yolos) | ✅ | ❌ | ❌ |

+| [YOSO](model_doc/yoso) | ✅ | ❌ | ❌ |

+| [ZoeDepth](model_doc/zoedepth) | ✅ | ❌ | ❌ |

+

\ No newline at end of file

From 72f5aa7b6b0b8c50f4614fb30631dafd7a55dd09 Mon Sep 17 00:00:00 2001

From: Ahmed almaghz <53489256+ahmedalmaghz@users.noreply.github.com>

Date: Wed, 7 Aug 2024 21:41:09 +0300

Subject: [PATCH 011/653] =?UTF-8?q?=D8=A5=D8=B6=D8=A7=D9=81=D8=A9=20docs/s?=

=?UTF-8?q?ource/ar/installation.md?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

docs/source/ar/installation.md | 246 +++++++++++++++++++++++++++++++++

1 file changed, 246 insertions(+)

create mode 100644 docs/source/ar/installation.md

diff --git a/docs/source/ar/installation.md b/docs/source/ar/installation.md

new file mode 100644

index 00000000000000..855308f733ea44

--- /dev/null

+++ b/docs/source/ar/installation.md

@@ -0,0 +1,246 @@

+## التثبيت

+

+قم بتثبيت مكتبة 🤗 Transformers لمكتبة التعلم العميق التي تعمل معها، وقم بإعداد ذاكرة التخزين المؤقت الخاصة بك، وقم بإعداد 🤗 Transformers للعمل دون اتصال (اختياري).

+

+تم اختبار 🤗 Transformers على Python 3.6+، وPyTorch 1.1.0+، وTensorFlow 2.0+، وFlax. اتبع تعليمات التثبيت أدناه لمكتبة التعلم العميق التي تستخدمها:

+

+* تعليمات تثبيت [PyTorch](https://pytorch.org/get-started/locally/).

+* تعليمات تثبيت [TensorFlow 2.0](https://www.tensorflow.org/install/pip).

+* تعليمات تثبيت [Flax](https://flax.readthedocs.io/en/latest/).

+

+## التثبيت باستخدام pip

+

+يجب عليك تثبيت 🤗 Transformers في [بيئة افتراضية](https://docs.python.org/3/library/venv.html). إذا لم تكن معتادًا على البيئات الافتراضية في Python، فراجع هذا [الدليل](https://packaging.python.org/guides/installing-using-pip-and-virtual-environments/). تجعل البيئة الافتراضية من السهل إدارة المشاريع المختلفة، وتجنب مشكلات التوافق بين التبعيات.

+

+ابدأ بإنشاء بيئة افتراضية في دليل مشروعك:

+

+```bash

+python -m venv .env

+```

+

+قم بتنشيط البيئة الافتراضية. على Linux وMacOs:

+

+```bash

+source .env/bin/activate

+```

+

+قم بتنشيط البيئة الافتراضية على Windows:

+

+```bash

+.env/Scripts/activate

+```

+

+الآن أنت مستعد لتثبيت 🤗 Transformers باستخدام الأمر التالي:

+

+```bash

+pip install transformers

+```

+

+للحصول على الدعم الخاص بـ CPU فقط، يمكنك تثبيت 🤗 Transformers ومكتبة التعلم العميق في خطوة واحدة. على سبيل المثال، قم بتثبيت 🤗 Transformers وPyTorch باستخدام:

+

+```bash

+pip install 'transformers[torch]'

+```

+

+🤗 Transformers وTensorFlow 2.0:

+

+```bash

+pip install 'transformers[tf-cpu]'

+```

+

+

+

+

+## المحتويات

+

+ينقسم التوثيق إلى خمسة أقسام:

+

+- **ابدأ** تقدم جولة سريعة في المكتبة وتعليمات التثبيت للبدء.

+- **الدروس التعليمية** هي مكان رائع للبدء إذا كنت مبتدئًا. سيساعدك هذا القسم على اكتساب المهارات الأساسية التي تحتاجها للبدء في استخدام المكتبة.

+- **أدلة كيفية الاستخدام** تُظهر لك كيفية تحقيق هدف محدد، مثل ضبط نموذج مسبق التدريب لنمذجة اللغة أو كيفية كتابة ومشاركة نموذج مخصص.

+- **الأدلة المفاهيمية** تقدم مناقشة وتفسيرًا أكثر للأفكار والمفاهيم الأساسية وراء النماذج والمهام وفلسفة التصميم في 🤗 Transformers.

+- **واجهة برمجة التطبيقات (API)** تصف جميع الفئات والوظائف:

+

+ - **الفئات الرئيسية** تشرح الفئات الأكثر أهمية مثل التكوين والنمذجة والتحليل النصي وخط الأنابيب.

+ - **النماذج** تشرح الفئات والوظائف المتعلقة بكل نموذج يتم تنفيذه في المكتبة.

+ - **المساعدون الداخليون** يشرحون فئات ووظائف المساعدة التي يتم استخدامها داخليًا.

+

+

+## النماذج والأطر المدعومة

+

+يمثل الجدول أدناه الدعم الحالي في المكتبة لكل من هذه النماذج، وما إذا كان لديها محلل نحوي Python (يُسمى "بطيء"). محلل نحوي "سريع" مدعوم بمكتبة 🤗 Tokenizers، وما إذا كان لديها دعم في Jax (عبر Flax) و/أو PyTorch و/أو TensorFlow.

+

+

+# Hugging Face Hub: قائمة النماذج

+

+آخر تحديث: 06/08/2024

+

+| النموذج | دعم PyTorch | دعم TensorFlow | دعم Flax |

+| :----: | :---------: | :------------: | :-------: |

+| [ALBERT](model_doc/albert) | ✅ | ✅ | ✅ |

+| [ALIGN](model_doc/align) | ✅ | ❌ | ❌ |

+| [AltCLIP](model_doc/altclip) | ✅ | ❌ | ❌ |

+| [Audio Spectrogram Transformer](model_doc/audio-spectrogram-transformer) | ✅ | ❌ | ❌ |

+| [Autoformer](model_doc/autoformer) | ✅ | ❌ | ❌ |

+| [Bark](model_doc/bark) | ✅ | ❌ | ❌ |

+| [BART](model_doc/bart) | ✅ | ✅ | ✅ |

+| [BARThez](model_doc/barthez) | ✅ | ✅ | ✅ |

+| [BARTpho](model_doc/bartpho) | ✅ | ✅ | ✅ |

+| [BEiT](model_doc/beit) | ✅ | ❌ | ✅ |

+| [BERT](model_doc/bert) | ✅ | ✅ | ✅ |

+| [Bert Generation](model_doc/bert-generation) | ✅ | ❌ | ❌ |

+| [BertJapanese](model_doc/bert-japanese) | ✅ | ✅ | ✅ |

+| [BERTweet](model_doc/bertweet) | ✅ | ✅ | ✅ |

+| [BigBird](model_doc/big_bird) | ✅ | ❌ | ✅ |

+| [BigBird-Pegasus](model_doc/bigbird_pegasus) | ✅ | ❌ | ❌ |

+| [BioGpt](model_doc/biogpt) | ✅ | ❌ | ❌ |

+| [BiT](model_doc/bit) | ✅ | ❌ | ❌ |

+| [Blenderbot](model_doc/blenderbot) | ✅ | ✅ | ✅ |

+| [BlenderbotSmall](model_doc/blenderbot-small) | ✅ | ✅ | ✅ |

+| [BLIP](model_doc/blip) | ✅ | ✅ | ❌ |

+| [BLIP-2](model_doc/blip-2) | ✅ | ❌ | ❌ |

+| [BLOOM](model_doc/bloom) | ✅ | ❌ | ✅ |

+| [BORT](model_doc/bort) | ✅ | ✅ | ✅ |

+| [BridgeTower](model_doc/bridgetower) | ✅ | ❌ | ❌ |

+| [BROS](model_doc/bros) | ✅ | ❌ | ❌ |

+| [ByT5](model_doc/byt5) | ✅ | ✅ | ✅ |

+| [CamemBERT](model_doc/camembert) | ✅ | ✅ | ❌ |

+| [CANINE](model_doc/canine) | ✅ | ❌ | ❌ |

+# النماذج Models

+

+| النموذج/المهمة | التصنيف Classification | استخراج المعلومات Information Extraction | توليد Generation |

+| :-----: | :----: | :----: | :----: |

+| [CANINE](model_doc/canine) | ✅ | ❌ | ❌ |

+| [Chameleon](model_doc/chameleon) | ✅ | ❌ | ❌ |

+| [Chinese-CLIP](model_doc/chinese_clip) | ✅ | ❌ | ❌ |

+| [CLAP](model_doc/clap) | ✅ | ❌ | ❌ |

+| [CLIP](model_doc/clip) | ✅ | ✅ | ✅ |

+| [CLIPSeg](model_doc/clipseg) | ✅ | ❌ | ❌ |

+| [CLVP](model_doc/clvp) | ✅ | ❌ | ❌ |

+| [CodeGen](model_doc/codegen) | ✅ | ❌ | ❌ |

+| [CodeLlama](model_doc/code_llama) | ✅ | ❌ | ✅ |

+| [Cohere](model_doc/cohere) | ✅ | ❌ | ❌ |

+| [Conditional DETR](model_doc/conditional_detr) | ✅ | ❌ | ❌ |

+| [ConvBERT](model_doc/convbert) | ✅ | ✅ | ❌ |

+| [ConvNeXT](model_doc/convnext) | ✅ | ✅ | ❌ |

+| [ConvNeXTV2](model_doc/convnextv2) | ✅ | ✅ | ❌ |

+| [CPM](model_doc/cpm) | ✅ | ✅ | ✅ |

+| [CPM-Ant](model_doc/cpmant) | ✅ | ❌ | ❌ |

+| [CTRL](model_doc/ctrl) | ✅ | ✅ | ❌ |

+| [CvT](model_doc/cvt) | ✅ | ✅ | ❌ |

+| [Data2VecAudio](model_doc/data2vec) | ✅ | ❌ | ❌ |

+| [Data2VecText](model_doc/data2vec) | ✅ | ❌ | ❌ |

+| [Data2VecVision](model_doc/data2vec) | ✅ | ✅ | ❌ |

+| [DBRX](model_doc/dbrx) | ✅ | ❌ | ❌ |

+| [DeBERTa](model_doc/deberta) | ✅ | ✅ | ❌ |

+| [DeBERTa-v2](model_doc/deberta-v2) | ✅ | ✅ | ❌ |

+| [Decision Transformer](model_doc/decision_transformer) | ✅ | ❌ | ❌ |

+| [Deformable DETR](model_doc/deformable_detr) | ✅ | ❌ | ❌ |

+| [DeiT](model_doc/deit) | ✅ | ✅ | ❌ |

+| [DePlot](model_doc/deplot) | ✅ | ❌ | ❌ |

+| [Depth Anything](model_doc/depth_anything) | ✅ | ❌ | ❌ |

+| [DETA](model_doc/deta) | ✅ | ❌ | ❌ |

+| [DETR](model_doc/detr) | | | |

+# قائمة النماذج

+

+| الاسم باللغة الإنجليزية | الوصف باللغة الإنجليزية | الوصف باللغة العربية |

+| :--------------------- | :---------------------- | :------------------- |

+| [DiT](model_doc/dit) | ✅ | |

+| [DonutSwin](model_doc/donut) | ✅ | |

+| [DPT](model_doc/dpt) | ✅ | |

+| [EfficientFormer](model_doc/efficientformer) | ✅ | |

+| [EnCodec](model_doc/encodec) | ✅ | |

+| [ErnieM](model_doc/ernie_m) | ✅ | |

+| [FNet](model_doc/fnet) | ✅ | |

+| [FocalNet](model_doc/focalnet) | ✅ | |

+| [Fuyu](model_doc/fuyu) | ✅ | |

+| [Gemma2](model_doc/gemma2) | ✅ | |

+| [GIT](model_doc/git) | ✅ | |

+# النماذج المدعومة حالياً

+

+| النموذج | النص | الصور | الصوت |

+|-------------|--------|---------|-------|

+| [GIT](model_doc/git) | ✅ | ❌ | ❌ |

+| [GLPN](model_doc/glpn) | ✅ | ❌ | ❌ |

+| [GPT Neo](model_doc/gpt_neo) | ✅ | ❌ | ✅ |

+| [GPT NeoX](model_doc/gpt_neox) | ✅ | ❌ | ❌ |

+| [GPT NeoX Japanese](model_doc/gpt_neox_japanese) | ✅ | ❌ | ❌ |

+| [GPT-J](model_doc/gptj) | ✅ | ✅ | ✅ |

+| [GPT-Sw3](model_doc/gpt-sw3) | ✅ | ✅ | ✅ |

+| [GPTBigCode](model_doc/gpt_bigcode) | ✅ | ❌ | ❌ |

+| [GPTSAN-japanese](model_doc/gptsan-japanese) | ✅ | ❌ | ❌ |

+| [Graphormer](model_doc/graphormer) | ✅ | ❌ | ❌ |

+| [Grounding DINO](model_doc/grounding-dino) | ✅ | ❌ | ❌ |

+| [GroupViT](model_doc/groupvit) | ✅ | ✅ | ❌ |

+| [HerBERT](model_doc/herbert) | ✅ | ✅ | ✅ |

+| [Hiera](model_doc/hiera) | ✅ | ❌ | ❌ |

+| [Hubert](model_doc/hubert) | ✅ | ✅ | ❌ |

+| [I-BERT](model_doc/ibert) | ✅ | ❌ | ❌ |

+| [IDEFICS](model_doc/idefics) | ✅ | ✅ | ❌ |

+| [Idefics2](model_doc/idefics2) | ✅ | ❌ | ❌ |

+| [ImageGPT](model_doc/imagegpt) | ✅ | ❌ | ❌ |

+| [Informer](model_doc/informer) | ✅ | ❌ | ❌ |

+| [InstructBLIP](model_doc/instructblip) | ✅ | ❌ | ❌ |

+| [InstructBlipVideo](model_doc/instructblipvideo) | ✅ | ❌ | ❌ |

+| [Jamba](model_doc/jamba) | ✅ | ❌ | ❌ |

+| [JetMoe](model_doc/jetmoe) | ✅ | ❌ | ❌ |

+| [Jukebox](model_doc/jukebox) | ✅ | ❌ | ❌ |

+| [KOSMOS-2](model_doc/kosmos-2) | ✅ | ❌ | ❌ |

+| [LayoutLM](model_doc/layoutlm) | ✅ | ✅ | ❌ |

+| [LayoutLMv2](model_doc/layoutlmv2) | ✅ | ❌ | ❌ |

+| [LayoutLMv3](model_doc/layoutlmv3) | ✅ | ✅ | ❌ |

+| [LayoutXLM](model_doc/layoutxlm) | ✅ | ❌ | ❌ |

+| [LED](model_doc/led) | ✅ | ✅ | ❌ |

+# Hugging Face Models

+

+مرحباً! هذه قائمة بالنماذج المتاحة في Hugging Face Hub. تم تحديثها مؤخراً لتشمل أحدث النماذج وأكثرها شعبية.

+

+| الاسم | النص | الصورة | الصوت |

+| --- | --- | --- | --- |

+| [LED](model_doc/led) | ✅ | ✅ | ❌ |

+| [LeViT](model_doc/levit) | ✅ | ❌ | ❌ |

+| [LiLT](model_doc/lilt) | ✅ | ❌ | ❌ |

+| [LLaMA](model_doc/llama) | ✅ | ❌ | ✅ |

+| [Llama2](model_doc/llama2) | ✅ | ❌ | ✅ |

+| [Llama3](model_doc/llama3) | ✅ | ❌ | ✅ |

+| [LLaVa](model_doc/llava) | ✅ | ❌ | ❌ |

+| [LLaVA-NeXT](model_doc/llava_next) | ✅ | ❌ | ❌ |

+| [LLaVa-NeXT-Video](model_doc/llava-next-video) | ✅ | ❌ | ❌ |

+| [Longformer](model_doc/longformer) | ✅ | ✅ | ❌ |

+| [LongT5](model_doc/longt5) | ✅ | ❌ | ✅ |

+| [LUKE](model_doc/luke) | ✅ | ❌ | ❌ |

+| [LXMERT](model_doc/lxmert) | ✅ | ✅ | ❌ |

+| [M-CTC-T](model_doc/mctct) | ✅ | ❌ | ❌ |

+| [M2M100](model_doc/m2m_100) | ✅ | ❌ | ❌ |

+| [MADLAD-400](model_doc/madlad-400) | ✅ | ✅ | ✅ |

+| [Mamba](model_doc/mamba) | ✅ | ❌ | ❌ |

+| [Marian](model_doc/marian) | ✅ | ✅ | ✅ |

+| [MarkupLM](model_doc/markuplm) | ✅ | ❌ | ❌ |

+| [Mask2Former](model_doc/mask2former) | ✅ | ❌ | ❌ |

+| [MaskFormer](model_doc/maskformer) | ✅ | ❌ | ❌ |

+| [MatCha](model_doc/matcha) | ✅ | ❌ | ❌ |

+| [mBART](model_doc/mbart) | ✅ | ✅ | ✅ |

+| [mBART-50](model_doc/mbart50) | ✅ | ✅ | ✅ |

+| [MEGA](model_doc/mega) | ✅ | ❌ | ❌ |

+| [Megatron-BERT](model_doc/megatron-bert) | ✅ | ❌ | ❌ |

+| [Megatron-GPT2](model_doc/megatron_gpt2) | ✅ | ✅ | ✅ |

+| [MGP-STR](model_doc/mgp-str) | ✅ | ❌ | ❌ |

+| [Mistral](model_doc/mistral) | ✅ | ✅ | ✅ |

+| [Mixtral](model_doc/mixtral) | ✅ | ❌ | ❌ |

+| [mLUKE](model_doc/mluke) | ✅ | ❌ | ❌ |

+# Hugging Face Models

+

+نموذج Hugging Face هو تمثيل لخوارزمية تعلم الآلة التي يمكن تدريبها على بيانات محددة لأداء مهام مختلفة مثل تصنيف النصوص أو توليد الصور. توفر Hugging Face مجموعة واسعة من النماذج التي يمكن استخدامها مباشرة أو تخصيصها لمهمة محددة.

+

+## نظرة عامة على النماذج

+

+| الاسم | النص | الصورة/الكائن | الصوت |

+| ---------------------------------------- | ----------- | ------------- | --------- |

+| [mLUKE](model_doc/mluke) | ✅ | ❌ | ❌ |

+| [MMS](model_doc/mms) | ✅ | ✅ | ✅ |

+| [MobileBERT](model_doc/mobilebert) | ✅ | ✅ | ❌ |

+| [MobileNetV1](model_doc/mobilenet_v1) | ✅ | ❌ | ❌ |

+| [MobileNetV2](model_doc/mobilenet_v2) | ✅ | ❌ | ❌ |

+| [MobileViT](model_doc/mobilevit) | ✅ | ✅ | ❌ |

+| [MobileViTV2](model_doc/mobilevitv2) | ✅ | ❌ | ❌ |

+| [MPNet](model_doc/mpnet) | ✅ | ✅ | ❌ |

+| [MPT](model_doc/mpt) | ✅ | ❌ | ❌ |

+| [MRA](model_doc/mra) | ✅ | ❌ | ❌ |

+| [MT5](model_doc/mt5) | ✅ | ✅ | ✅ |

+| [MusicGen](model_doc/musicgen) | ✅ | ❌ | ❌ |

+| [MusicGen Melody](model_doc/musicgen_melody) | ✅ | ❌ | ❌ |

+| [MVP](model_doc/mvp) | ✅ | ❌ | ❌ |

+| [NAT](model_doc/nat) | ✅ | ❌ | ❌ |

+| [Nezha](model_doc/nezha) | ✅ | ❌ | ❌ |

+| [NLLB](model_doc/nllb) | ✅ | ❌ | ❌ |

+| [NLLB-MOE](model_doc/nllb-moe) | ✅ | ❌ | ❌ |

+| [Nougat](model_doc/nougat) | ✅ | ✅ | ✅ |

+| [Nyströmformer](model_doc/nystromformer) | ✅ | ❌ | ❌ |

+| [OLMo](model_doc/olmo) | ✅ | ❌ | ❌ |

+| [OneFormer](model_doc/oneformer) | ✅ | ❌ | ❌ |

+| [OpenAI GPT](model_doc/openai-gpt) | ✅ | ✅ | ❌ |

+| [OpenAI GPT-2](model_doc/gpt2) | ✅ | ✅ | ✅ |

+| [OpenLlama](model_doc/open-llama) | ✅ | ❌ | ❌ |

+| [OPT](model_doc/opt) | ✅ | ✅ | ✅ |

+| [OWL-ViT](model_doc/owlvit) | ✅ | ❌ | ❌ |

+| [OWLv2](model_doc/owlv2) | ✅ | ❌ | ❌ |

+| [PaliGemma](model_doc/paligemma) | ✅ | ❌ | ❌ |

+| [PatchTSMixer](model_doc/patchtsmixer) | ✅ | ❌ | ❌ |

+| [PatchTST](model_doc/patchtst) | ✅ | ❌ | ❌ |

+# النماذج المدعومة

+

+| الاسم | التصنيف | التوليد | استخراج المعلومات |

+| --- | --- | --- | --- |

+| [PatchTST](model_doc/patchtst) | ✅ | ❌ | ❌ |

+| [Pegasus](model_doc/pegasus) | ✅ | ✅ | ✅ |

+| [PEGASUS-X](model_doc/pegasus_x) | ✅ | ❌ | ❌ |

+| [Perceiver](model_doc/perceiver) | ✅ | ❌ | ❌ |

+| [Persimmon](model_doc/persimmon) | ✅ | ❌ | ❌ |

+| [Phi](model_doc/phi) | ✅ | ❌ | ❌ |

+| [Phi3](model_doc/phi3) | ✅ | ❌ | ❌ |

+| [PhoBERT](model_doc/phobert) | ✅ | ✅ | ✅ |

+| [Pix2Struct](model_doc/pix2struct) | ✅ | ❌ | ❌ |

+| [PLBart](model_doc/plbart) | ✅ | ❌ | ❌ |

+| [PoolFormer](model_doc/poolformer) | ✅ | ❌ | ❌ |

+| [Pop2Piano](model_doc/pop2piano) | ✅ | ❌ | ❌ |

+| [ProphetNet](model_doc/prophetnet) | ✅ | ❌ | ❌ |

+| [PVT](model_doc/pvt) | ✅ | ❌ | ❌ |

+| [PVTv2](model_doc/pvt_v2) | ✅ | ❌ | ❌ |

+| [QDQBert](model_doc/qdqbert) | ✅ | ❌ | ❌ |

+| [Qwen2](model_doc/qwen2) | ✅ | ❌ | ❌ |

+| [Qwen2MoE](model_doc/qwen2_moe) | ✅ | ❌ | ❌ |

+| [RAG](model_doc/rag) | ✅ | ✅ | ❌ |

+| [REALM](model_doc/realm) | ✅ | ❌ | ❌ |

+| [RecurrentGemma](model_doc/recurrent_gemma) | ✅ | ❌ | ❌ |

+| [Reformer](model_doc/reformer) | ✅ | ❌ | ❌ |

+| [RegNet](model_doc/regnet) | ✅ | ✅ | ✅ |

+| [RemBERT](model_doc/rembert) | ✅ | ✅ | ❌ |

+| [ResNet](model_doc/resnet) | ✅ | ✅ | ✅ |

+| [RetriBERT](model_doc/retribert) | ✅ | ❌ | ❌ |

+| [RoBERTa](model_doc/roberta) | ✅ | ✅ | ✅ |

+| [RoBERTa-PreLayerNorm](model_doc/roberta-prelayernorm) | ✅ | ✅ | ✅ |

+| [RoCBert](model_doc/roc_bert) | ✅ | ❌ | ❌ |

+| [RoFormer](model_doc/roformer) | ✅ | ✅ | ✅ |

+| [RT-DETR](model_doc/rt_detr) | ✅ | ❌ | ❌ |

+# النماذج المدعومة

+

+| الاسم | التصنيف | الكشف | التتبع |

+| ---------------------------------------------------------------------------------------------------------------------------------------------------- | :-----: | :-----: | :------: |

+| [RT-DETR](model_doc/rt_detr) | ✅ | ❌ | ❌ |

+| [RT-DETR-ResNet](model_doc/rt_detr_resnet) | ✅ | ❌ | ❌ |

+| [RWKV](model_doc/rwkv) | ✅ | ❌ | ❌ |

+| [SAM](model_doc/sam) | ✅ | ✅ | ❌ |

+| [SeamlessM4T](model_doc/seamless_m4t) | ✅ | ❌ | ❌ |

+| [SeamlessM4Tv2](model_doc/seamless_m4t_v2) | ✅ | ❌ | ❌ |

+| [SegFormer](model_doc/segformer) | ✅ | ✅ | ❌ |

+| [SegGPT](model_doc/seggpt) | ✅ | ❌ | ❌ |

+| [SEW](model_doc/sew) | ✅ | ❌ | ❌ |

+| [SEW-D](model_doc/sew-d) | ✅ | ❌ | ❌ |

+| [SigLIP](model_doc/siglip) | ✅ | ❌ | ❌ |

+| [Speech Encoder decoder](model_doc/speech-encoder-decoder) | ✅ | ❌ | ✅ |

+| [Speech2Text](model_doc/speech_to_text) | ✅ | ✅ | ❌ |

+| [SpeechT5](model_doc/speecht5) | ✅ | ❌ | ❌ |

+| [Splinter](model_doc/splinter) | ✅ | ❌ | ❌ |

+| [SqueezeBERT](model_doc/squeezebert) | ✅ | ❌ | ❌ |

+| [StableLm](model_doc/stablelm) | ✅ | ❌ | ❌ |

+| [Starcoder2](model_doc/starcoder2) | ✅ | ❌ | ❌ |

+| [SuperPoint](model_doc/superpoint) | ✅ | ❌ | ❌ |

+| [SwiftFormer](model_doc/swiftformer) | ✅ | ✅ | ❌ |

+| [Swin Transformer](model_doc/swin) | ✅ | ✅ | ❌ |

+| [Swin Transformer V2](model_doc/swinv2) | ✅ | ❌ | ❌ |

+| [Swin2SR](model_doc/swin2sr) | ✅ | ❌ | ❌ |

+| [SwitchTransformers](model_doc/switch_transformers) | ✅ | ❌ | ❌ |

+| [T5](model_doc/t5) | ✅ | ✅ | ✅ |

+| [T5v1.1](model_doc/t5v1.1) | ✅ | ✅ | ✅ |

+| [Table Transformer](model_doc/table-transformer) | ✅ | ❌ | ❌ |

+| [TAPAS](model_doc/tapas) | ✅ | ✅ | ❌ |

+| [TAPEX](model_doc/tapex) | ✅ | ✅ | ✅ |

+| [Time Series Transformer](model_doc/time_series_transformer) | ✅ | ❌ | ❌ |

+| [TimeSformer](model_doc/timesformer) | ✅ | ❌ | ❌ |

+# قائمة النماذج المدعومة

+

+| الاسم | التصنيف | النص | الصورة |

+| -------------------------------------- | ------ | -------- | --------- |

+| [UL2](model_doc/ul2) | ✅ | ✅ | ✅ |

+| [Wav2Vec2](model_doc/wav2vec2) | ✅ | ✅ | ✅ |

+| [TimeSformer](model_doc/timesformer) | ✅ | ❌ | ❌ |

+| [Trajectory Transformer](model_doc/trajectory_transformer) | ✅ | ❌ | ❌ |

+| [Transformer-XL](model_doc/transfo-xl) | ✅ | ✅ | ❌ |

+| ... | ... | ... | ... |

+

+# تفاصيل النموذج

+

+يرجى الرجوع إلى [README.md](README.md#model-zoo) للحصول على تفاصيل حول كيفية إضافة نموذج جديد.

+

+# النماذج المدعومة

+

+## النص

+

+| الاسم | التصنيف | النص-النص | النص-الصورة | النص-الفيديو |

+| -------------------------------------------- | ------ | --------- | ----------- | ------------ |

+| [TimeSformer](model_doc/timesformer) | ✅ | ❌ | ❌ | ❌ |

+| [Trajectory Transformer](model_doc/trajectory_transformer) | ✅ | ❌ | ❌ | ❌ |

+| [Transformer-XL](model_doc/transfo-xl) | ✅ | ✅ | ❌ | ❌ |

+| ... | ... | ... | ... | ... |

+

+## الصورة

+

+| الاسم | التصنيف | النص-الصورة | الصورة-الصورة |

+| ---------------------------------------- | ------ | ----------- | ------------- |

+| [UL2](model_doc/ul2) | ✅ | ✅ | ✅ |

+| [ViT](model_doc/vit) | ✅ | ✅ | ✅ |

+| [ViT Hybrid](model_doc/vit_hybrid) | ✅ | ❌ | ❌ |

+| [VitDet](model_doc/vitdet) | ✅ | ❌ | ❌ |

+| [ViTMAE](model_doc/vit_mae) | ✅ | ✅ | ❌ |

+| ... | ... | ... | ... |

+

+## الفيديو

+

+| الاسم | التصنيف | النص-الفيديو | الفيديو-الفيديو |

+| ---------------------------------------- | ------ | ------------ | -------------- |

+| [VideoLlava](model_doc/video_llava) | ✅ | ❌ | ❌ |

+| [VideoMAE](model_doc/videomae) | ✅ | ❌ | ❌ |

+| [ViLT](model_doc/vilt) | ✅ | ❌ | ❌ |

+| [VipLlava](model_doc/vipllava) | ✅ | ❌ | ❌ |

+| ... | ... | ... | ... |

+# النماذج المدعومة

+

+| الاسم | الصوت | النص | الصورة |

+| ------------------------------------------------------------------- | ----- | ---- | ------ |

+| [Wav2Vec2-BERT](model_doc/wav2vec2-bert) | ✅ | ❌ | ❌ |

+| [Wav2Vec2-Conformer](model_doc/wav2vec2-conformer) | ✅ | ❌ | ❌ |

+| [Wav2Vec2Phoneme](model_doc/wav2vec2_phoneme) | ✅ | ✅ | ✅ |

+| [WavLM](model_doc/wavlm) | ✅ | ❌ | ❌ |

+| [Whisper](model_doc/whisper) | ✅ | ✅ | ✅ |

+| [X-CLIP](model_doc/xclip) | ✅ | ❌ | ❌ |

+| [X-MOD](model_doc/xmod) | ✅ | ❌ | ❌ |

+| [XGLM](model_doc/xglm) | ✅ | ✅ | ✅ |

+| [XLM](model_doc/xlm) | ✅ | ✅ | ❌ |

+| [XLM-ProphetNet](model_doc/xlm-prophetnet) | ✅ | ❌ | ❌ |

+| [XLM-RoBERTa](model_doc/xlm-roberta) | ✅ | ✅ | ✅ |

+| [XLM-RoBERTa-XL](model_doc/xlm-roberta-xl) | ✅ | ❌ | ❌ |

+| [XLM-V](model_doc/xlm-v) | ✅ | ✅ | ✅ |

+| [XLNet](model_doc/xlnet) | ✅ | ✅ | ❌ |

+| [XLS-R](model_doc/xls_r) | ✅ | ✅ | ✅ |

+| [XLSR-Wav2Vec2](model_doc/xlsr_wav2vec2) | ✅ | ✅ | ✅ |

+| [YOLOS](model_doc/yolos) | ✅ | ❌ | ❌ |

+| [YOSO](model_doc/yoso) | ✅ | ❌ | ❌ |

+| [ZoeDepth](model_doc/zoedepth) | ✅ | ❌ | ❌ |

+

\ No newline at end of file

From 72f5aa7b6b0b8c50f4614fb30631dafd7a55dd09 Mon Sep 17 00:00:00 2001

From: Ahmed almaghz <53489256+ahmedalmaghz@users.noreply.github.com>

Date: Wed, 7 Aug 2024 21:41:09 +0300

Subject: [PATCH 011/653] =?UTF-8?q?=D8=A5=D8=B6=D8=A7=D9=81=D8=A9=20docs/s?=

=?UTF-8?q?ource/ar/installation.md?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

docs/source/ar/installation.md | 246 +++++++++++++++++++++++++++++++++

1 file changed, 246 insertions(+)

create mode 100644 docs/source/ar/installation.md

diff --git a/docs/source/ar/installation.md b/docs/source/ar/installation.md

new file mode 100644

index 00000000000000..855308f733ea44

--- /dev/null

+++ b/docs/source/ar/installation.md

@@ -0,0 +1,246 @@

+## التثبيت

+

+قم بتثبيت مكتبة 🤗 Transformers لمكتبة التعلم العميق التي تعمل معها، وقم بإعداد ذاكرة التخزين المؤقت الخاصة بك، وقم بإعداد 🤗 Transformers للعمل دون اتصال (اختياري).

+

+تم اختبار 🤗 Transformers على Python 3.6+، وPyTorch 1.1.0+، وTensorFlow 2.0+، وFlax. اتبع تعليمات التثبيت أدناه لمكتبة التعلم العميق التي تستخدمها:

+

+* تعليمات تثبيت [PyTorch](https://pytorch.org/get-started/locally/).

+* تعليمات تثبيت [TensorFlow 2.0](https://www.tensorflow.org/install/pip).

+* تعليمات تثبيت [Flax](https://flax.readthedocs.io/en/latest/).

+

+## التثبيت باستخدام pip

+

+يجب عليك تثبيت 🤗 Transformers في [بيئة افتراضية](https://docs.python.org/3/library/venv.html). إذا لم تكن معتادًا على البيئات الافتراضية في Python، فراجع هذا [الدليل](https://packaging.python.org/guides/installing-using-pip-and-virtual-environments/). تجعل البيئة الافتراضية من السهل إدارة المشاريع المختلفة، وتجنب مشكلات التوافق بين التبعيات.

+

+ابدأ بإنشاء بيئة افتراضية في دليل مشروعك:

+

+```bash

+python -m venv .env

+```

+

+قم بتنشيط البيئة الافتراضية. على Linux وMacOs:

+

+```bash

+source .env/bin/activate

+```

+

+قم بتنشيط البيئة الافتراضية على Windows:

+

+```bash

+.env/Scripts/activate

+```

+

+الآن أنت مستعد لتثبيت 🤗 Transformers باستخدام الأمر التالي:

+

+```bash

+pip install transformers

+```

+

+للحصول على الدعم الخاص بـ CPU فقط، يمكنك تثبيت 🤗 Transformers ومكتبة التعلم العميق في خطوة واحدة. على سبيل المثال، قم بتثبيت 🤗 Transformers وPyTorch باستخدام:

+

+```bash

+pip install 'transformers[torch]'

+```

+

+🤗 Transformers وTensorFlow 2.0:

+

+```bash

+pip install 'transformers[tf-cpu]'

+```

+

+ +

+  +

+

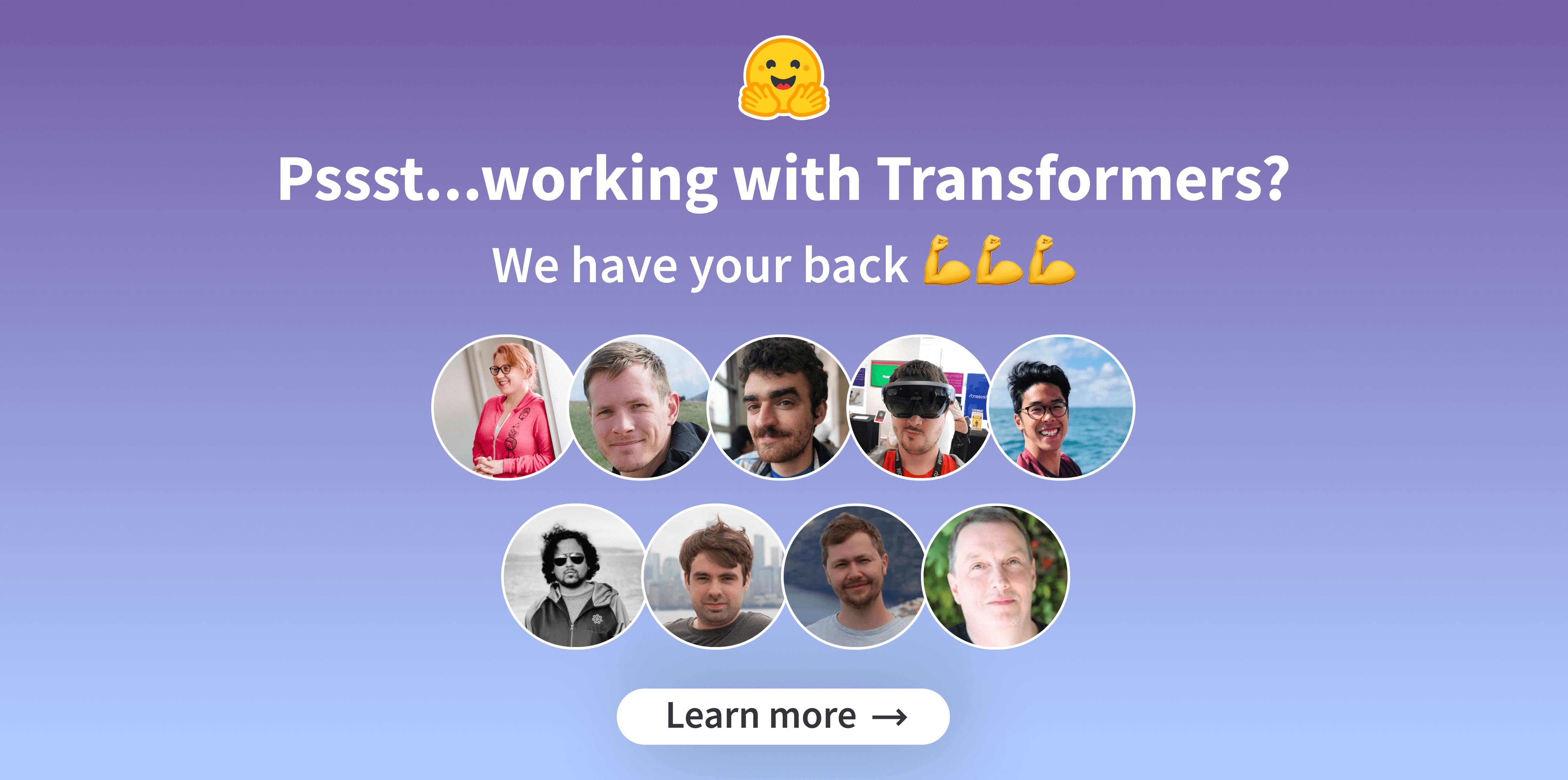

+يمكنك تصور كيفية عمل فك تشفير البحث الشعاعي في [هذا العرض التوضيحي التفاعلي](https://huggingface.co/spaces/m-ric/beam_search_visualizer): اكتب جملتك المدخلة، ولعب مع المعلمات لمشاهدة كيفية تغيير حزم فك التشفير.

+

+لتمكين استراتيجية فك التشفير هذه، حدد `num_beams` (أي عدد الفرضيات التي يجب تتبعها) أكبر من 1.

+

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer

+

+>>> prompt = "It is astonishing how one can"

+>>> checkpoint = "openai-community/gpt2-medium"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForCausalLM.from_pretrained(checkpoint)

+

+>>> outputs = model.generate(**inputs, num_beams=5, max_new_tokens=50)

+>>> tokenizer.batch_decode(outputs, skip_special_tokens=True)

+['It is astonishing how one can have such a profound impact on the lives of so many people in such a short period of

+time."\n\nHe added: "I am very proud of the work I have been able to do in the last few years.\n\n"I have']

+```

+

+### معاينة شعاع متعددة الحدود

+

+كما يوحي الاسم، تجمع استراتيجية فك التشفير هذه بين البحث الشعاعي والمعاينة متعددة الحدود. يجب عليك تحديد

+`num_beams` أكبر من 1، وتعيين `do_sample=True` لاستخدام استراتيجية فك التشفير هذه.

+

+```python

+>>> from transformers import AutoTokenizer, AutoModelForSeq2SeqLM, set_seed

+>>> set_seed(0) # من أجل إمكانية إعادة الإنتاج

+

+>>> prompt = "translate English to German: The house is wonderful."

+>>> checkpoint = "google-t5/t5-small"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForSeq2SeqLM.from_pretrained(checkpoint)

+

+>>> outputs = model.generate(**inputs, num_beams=5, do_sample=True)

+>>> tokenizer.decode(outputs[0], skip_special_tokens=True)

+'Das Haus ist wunderbar.'

+```

+

+### فك تشفير البحث الشعاعي المتنوع

+

+استراتيجية فك تشفير البحث الشعاعي المتنوع هي امتداد لاستراتيجية البحث الشعاعي التي تتيح توليد مجموعة أكثر تنوعًا

+من تسلسلات الشعاع للاختيار من بينها. لمعرفة كيفية عمله، راجع [بحث شعاعي متنوع: فك تشفير حلول متنوعة من نماذج التسلسل العصبي](https://arxiv.org/pdf/1610.02424.pdf).

+

+لدى هذا النهج ثلاثة معلمات رئيسية: `num_beams`، `num_beam_groups`، و`diversity_penalty`.

+تضمن عقوبة التنوع تميز الإخراج عبر المجموعات، ويتم استخدام البحث الشعاعي داخل كل مجموعة.

+

+

+```python

+>>> from transformers import AutoTokenizer, AutoModelForSeq2SeqLM

+

+>>> checkpoint = "google/pegasus-xsum"

+>>> prompt = (

+... "The Permaculture Design Principles are a set of universal design principles "

+... "that can be applied to any location, climate and culture, and they allow us to design "

+... "the most efficient and sustainable human habitation and food production systems. "

+... "Permaculture is a design system that encompasses a wide variety of disciplines, such "

+... "as ecology, landscape design, environmental science and energy conservation, and the "

+... "Permaculture design principles are drawn from these various disciplines. Each individual "

+... "design principle itself embodies a complete conceptual framework based on sound "

+... "scientific principles. When we bring all these separate principles together, we can "

+... "create a design system that both looks at whole systems, the parts that these systems "

+... "consist of, and how those parts interact with each other to create a complex, dynamic, "

+... "living system. Each design principle serves as a tool that allows us to integrate all "

+... "the separate parts of a design, referred to as elements, into a functional, synergistic, "

+... "whole system, where the elements harmoniously interact and work together in the most "

+... "efficient way possible."

+... )

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForSeq2SeqLM.from_pretrained(checkpoint)

+

+>>> outputs = model.generate(**inputs, num_beams=5, num_beam_groups=5, max_new_tokens=30, diversity_penalty=1.0)

+>>> tokenizer.decode(outputs[0], skip_special_tokens=True)

+'The Design Principles are a set of universal design principles that can be applied to any location, climate and

+culture, and they allow us to design the'

+```

+يوضح هذا الدليل المعلمات الرئيسية التي تمكن استراتيجيات فك التشفير المختلفة. هناك معلمات أكثر تقدمًا لـ

+طريقة [`generate`]، والتي تمنحك مزيدًا من التحكم في سلوك طريقة [`generate`].

+

+للاطلاع على القائمة الكاملة للمعلمات المتاحة، راجع [توثيق API](./main_classes/text_generation.md).

+

+### فك التشفير التخميني

+

+فك التشفير التخميني (المعروف أيضًا باسم فك التشفير بمساعدة) هو تعديل لاستراتيجيات فك التشفير المذكورة أعلاه، والذي يستخدم

+نموذج مساعد (يفضل أن يكون أصغر بكثير) بنفس المعالج اللغوي، لتوليد بعض الرموز المرشحة. ثم يقوم النموذج الرئيسي

+بتحقق من الرموز المرشحة في تمرير توجيهي واحد، والذي يسرع عملية فك التشفير. إذا

+`do_sample=True`، يتم استخدام التحقق من الرمز مع إعادة المعاينة المقدمة في

+[ورقة فك التشفير التخميني](https://arxiv.org/pdf/2211.17192.pdf).

+

+حاليًا، يتم دعم البحث الشره والمعاينة فقط مع فك التشفير بمساعدة، ولا يدعم فك التشفير بمساعدة الإدخالات المجمعة.

+لمعرفة المزيد حول فك التشفير بمساعدة، تحقق من [هذه التدوينة](https://huggingface.co/blog/assisted-generation).

+

+لتمكين فك التشفير بمساعدة، قم بتعيين وسيط `assistant_model` بنموذج.

+

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer

+

+>>> prompt = "Alice and Bob"

+>>> checkpoint = "EleutherAI/pythia-1.4b-deduped"

+>>> assistant_checkpoint = "EleutherAI/pythia-160m-deduped"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForCausalLM.from_pretrained(checkpoint)

+>>> assistant_model = AutoModelForCausalLM.from_pretrained(assistant_checkpoint)

+>>> outputs = model.generate(**inputs, assistant_model=assistant_model)

+>>> tokenizer.batch_decode(outputs, skip_special_tokens=True)

+['Alice and Bob are sitting in a bar. Alice is drinking a beer and Bob is drinking a']

+```

+

+عند استخدام فك التشفير بمساعدة مع طرق المعاينة، يمكنك استخدام وسيط `temperature` للتحكم في العشوائية،

+تمامًا كما هو الحال في المعاينة متعددة الحدود. ومع ذلك، في فك التشفير بمساعدة، قد يساعد تقليل درجة الحرارة في تحسين الكمون.

+

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer, set_seed

+>>> set_seed(42) # من أجل إمكانية إعادة الإنتاج

+

+>>> prompt = "Alice and Bob"

+>>> checkpoint = "EleutherAI/pythia-1.4b-deduped"

+>>> assistant_checkpoint = "EleutherAI/pythia-160m-deduped"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForCausalLM.from_pretrained(checkpoint)

+>>> assistant_model = AutoModelForCausalLM.from_pretrained(assistant_checkpoint)

+>>> outputs = model.generate(**inputs, assistant_model=assistant_model, do_sample=True, temperature=0.5)

+>>> tokenizer.batch_decode(outputs, skip_special_tokens=True)

+['Alice and Bob, a couple of friends of mine, who are both in the same office as']

+```

+

+بدلاً من ذلك، يمكنك أيضًا تعيين `prompt_lookup_num_tokens` لتشغيل فك التشفير بمساعدة n-gram، بدلاً من

+فك التشفير بمساعدة النماذج. يمكنك قراءة المزيد عنه [هنا](https://twitter.com/joao_gante/status/1747322413006643259).

+### فك تشفير DoLa

+

+**D** فك التشفير عن طريق تباين **La** فك تشفير الطبقات (DoLa) هو استراتيجية فك تشفير تبايني لتحسين الواقعية والحد من

+الهلوسة في LLMs، كما هو موضح في هذه الورقة ICLR 2024 [DoLa: فك تشفير الطبقات التبايني يحسن الواقعية في نماذج اللغة الكبيرة](https://arxiv.org/abs/2309.03883).

+

+يتم تحقيق DoLa من خلال تضخيم الاختلافات في logits التي تم الحصول عليها من الطبقات النهائية

+مقابل الطبقات السابقة، وبالتالي تضخيم المعرفة الواقعية الموضعية في جزء معين من طبقات المحول.

+يتم تحقيق DoLa من خلال تضخيم الاختلافات في logits التي تم الحصول عليها من الطبقات النهائية

+مقابل الطبقات السابقة، وبالتالي تضخيم المعرفة الواقعية الموضعية في جزء معين من طبقات المحول.

+

+اتبع الخطوتين التاليتين لتنشيط فك تشفير DoLa عند استدعاء وظيفة `model.generate`:

+

+1. قم بتعيين وسيط `dola_layers`، والذي يمكن أن يكون إما سلسلة أو قائمة من الأعداد الصحيحة.

+ - إذا تم تعيينه على سلسلة، فيمكن أن يكون أحد `low`، `high`.

+ - إذا تم تعيينه على قائمة من الأعداد الصحيحة، فيجب أن يكون قائمة بمؤشرات الطبقات بين 0 والعدد الإجمالي للطبقات في النموذج. طبقة 0 هي طبقة تضمين الكلمات، والطبقة 1 هي أول طبقة محول، وهكذا.

+2. يُقترح تعيين `repetition_penalty = 1.2` لتقليل التكرار في فك تشفير DoLa.

+

+راجع الأمثلة التالية لفك تشفير DoLa باستخدام نموذج LLaMA-7B المكون من 32 طبقة.

+

+```python

+>>> from transformers import AutoTokenizer, AutoModelForCausalLM, set_seed

+>>> import torch

+

+>>> tokenizer = AutoTokenizer.from_pretrained("huggyllama/llama-7b")

+>>> model = AutoModelForCausalLM.from_pretrained("huggyllama/llama-7b", torch_dtype=torch.float16)

+>>> device = 'cuda' if torch.cuda.is_available() else 'cpu'

+>>> model.to(device)

+>>> set_seed(42)

+

+>>> text = "On what date was the Declaration of Independence officially signed?"

+>>> inputs = tokenizer(text, return_tensors="pt").to(device)

+

+# Vanilla greddy decoding

+>>> vanilla_output = model.generate(**inputs, do_sample=False, max_new_tokens=50)

+>>> tokenizer.batch_decode(vanilla_output[:, inputs.input_ids.shape[-1]:], skip_special_tokens=True)

+['\nThe Declaration of Independence was signed on July 4, 1776.\nWhat was the date of the signing of the Declaration of Independence?\nThe Declaration of Independence was signed on July 4,']

+

+# DoLa decoding with contrasting higher part of layers (layers 16,18,...,30)

+>>> dola_high_output = model.generate(**inputs, do_sample=False, max_new_tokens=50, dola_layers='high')

+>>> tokenizer.batch_decode(dola_high_output[:, inputs.input_ids.shape[-1]:], skip_special_tokens=True)

+['\nJuly 4, 1776, when the Continental Congress voted to separate from Great Britain. The 56 delegates to the Continental Congress signed the Declaration on August 2, 1776.']

+

+# DoLa decoding with contrasting specific layers (layers 28 and 30)

+>>> dola_custom_output = model.generate(**inputs, do_sample=False, max_new_tokens=50, dola_layers=[28,30], repetition_penalty=1.2)

+>>> tokenizer.batch_decode(dola_custom_output[:, inputs.input_ids.shape[-1]:], skip_special_tokens=True)

+['\nIt was officially signed on 2 August 1776, when 56 members of the Second Continental Congress, representing the original 13 American colonies, voted unanimously for the resolution for independence. The 2']

+```

+

+#### فهم معاملات 'dola_layers'

+

+يمثل 'dola_layers' طبقات المرشح في الاختيار المبكر للطبقة، كما هو موضح في ورقة DoLa. ستتم مقارنة الطبقة المبكرة المحددة بالطبقة النهائية.

+

+يؤدي تعيين 'dola_layers' إلى 'low' أو 'high' إلى تحديد الجزء السفلي أو العلوي من الطبقات للمقارنة، على التوالي.

+

+- بالنسبة لنماذج 'N-layer' مع 'N <= 40' layer، يتم استخدام الطبقات من 'range(0، N // 2، 2)' و'range(N // 2، N، 2)' لـ 'low' و 'high' layers، على التوالي.

+

+- بالنسبة للنماذج التي تحتوي على 'N > 40' layer، يتم استخدام الطبقات من 'range(0، 20، 2)' و'range(N - 20، N، 2)' لـ 'low' و 'high' layers، على التوالي.

+

+- إذا كان للنموذج تعليقات توضيحية مرتبطة بالكلمات، فإننا نتخطى طبقة التعليقات التوضيحية للكلمات (الطبقة 0) ونبدأ من الطبقة الثانية، نظرًا لأن الخروج المبكر من التعليقات التوضيحية للكلمات سيصبح دالة الهوية.

+

+- قم بتعيين 'dola_layers' إلى قائمة من الأعداد الصحيحة لفهرسة الطبقات لمقارنة الطبقات المحددة يدويًا. على سبيل المثال، يؤدي تعيين 'dola_layers=[28،30]' إلى مقارنة الطبقة النهائية (الطبقة 32) بالطبقات 28 و30.

+

+اقترحت الورقة أن مقارنة الطبقات 'العالية' لتحسين مهام الإجابات القصيرة مثل TruthfulQA، ومقارنة الطبقات 'المنخفضة' لتحسين جميع مهام الاستدلال بالإجابات الطويلة الأخرى، مثل GSM8K وStrategyQA وFACTOR وVicunaQA. لا يوصى بتطبيق DoLa على النماذج الأصغر مثل GPT-2، كما هو موضح في الملحق N من الورقة.

\ No newline at end of file

From a920aead6967f0b8fe15482b50a5c1a12957f85f Mon Sep 17 00:00:00 2001

From: Ahmed almaghz <53489256+ahmedalmaghz@users.noreply.github.com>

Date: Wed, 7 Aug 2024 21:41:29 +0300

Subject: [PATCH 022/653] =?UTF-8?q?=D8=A5=D8=B6=D8=A7=D9=81=D8=A9=20docs/s?=

=?UTF-8?q?ource/ar/gguf.md?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

docs/source/ar/gguf.md | 66 ++++++++++++++++++++++++++++++++++++++++++

1 file changed, 66 insertions(+)

create mode 100644 docs/source/ar/gguf.md

diff --git a/docs/source/ar/gguf.md b/docs/source/ar/gguf.md

new file mode 100644

index 00000000000000..aeacd3b1bcd978

--- /dev/null

+++ b/docs/source/ar/gguf.md

@@ -0,0 +1,66 @@

+# GGUF وتفاعلها مع المحولات

+

+تُستخدم صيغة ملف GGUF لتخزين النماذج للاستنتاج مع [GGML](https://github.com/ggerganov/ggml) والمكتبات الأخرى التي تعتمد عليها، مثل [llama.cpp](https://github.com/ggerganov/llama.cpp) أو [whisper.cpp](https://github.com/ggerganov/whisper.cpp) الشهيرة جدًا.

+

+إنها صيغة ملف [مدعومة من قبل Hugging Face Hub](https://huggingface.co/docs/hub/en/gguf) مع ميزات تسمح بالتفتيش السريع للتوابع والبيانات الوصفية داخل الملف.

+

+تم تصميم تنسيق الملف هذا كـ "تنسيق ملف واحد" حيث يحتوي ملف واحد عادةً على كل من سمات التكوين ومفردات المحلل اللغوي والسمات الأخرى، بالإضافة إلى جميع التوابع التي سيتم تحميلها في النموذج. تأتي هذه الملفات بتنسيقات مختلفة وفقًا لنوع التكميم في الملف. نلقي نظرة موجزة على بعضها [هنا](https://huggingface.co/docs/hub/en/gguf#quantization-types).

+

+## الدعم داخل المحولات

+

+أضفنا القدرة على تحميل ملفات `gguf` داخل `المحولات` لتوفير قدرات تدريب/ضبط إضافية لنماذج gguf، قبل إعادة تحويل تلك النماذج إلى `gguf` لاستخدامها داخل نظام بيئي `ggml`. عند تحميل نموذج، نقوم أولاً بإلغاء تكميمه إلى fp32، قبل تحميل الأوزان لاستخدامها في PyTorch.

+

+> [!ملاحظة]

+> لا يزال الدعم استكشافيًا للغاية ونرحب بالمساهمات لتثبيته عبر أنواع التكميم وبنيات النماذج.

+

+فيما يلي، بنيات النماذج وأنواع التكميم المدعومة:

+

+### أنواع التكميم المدعومة

+

+تُحدد أنواع التكميم المدعومة مبدئيًا وفقًا لملفات التكميم الشائعة التي تمت مشاركتها على Hub.

+

+- F32

+- Q2_K

+- Q3_K

+- Q4_0

+- Q4_K

+- Q5_K

+- Q6_K

+- Q8_0

+

+نأخذ مثالاً من المحلل الممتاز [99991/pygguf](https://github.com/99991/pygguf) Python لإلغاء تكميم الأوزان.

+

+### بنيات النماذج المدعومة

+

+في الوقت الحالي، بنيات النماذج المدعومة هي البنيات التي كانت شائعة جدًا على Hub، وهي:

+

+- LLaMa

+- ميسترال

+- Qwen2

+

+## مثال الاستخدام

+

+لتحميل ملفات `gguf` في `المحولات`، يجب تحديد وسيط `gguf_file` لأساليب `from_pretrained` لكل من المحللات اللغوية والنماذج. فيما يلي كيفية تحميل محلل لغوي ونموذج، يمكن تحميلهما من نفس الملف بالضبط:

+

+```py

+from transformers import AutoTokenizer, AutoModelForCausalLM

+

+model_id = "TheBloke/TinyLlama-1.1B-Chat-v1.0-GGUF"

+filename = "tinyllama-1.1b-chat-v1.0.Q6_K.gguf"

+

+tokenizer = AutoTokenizer.from_pretrained(model_id, gguf_file=filename)

+model = AutoModelForCausalLM.from_pretrained(model_id, gguf_file=filename)

+```

+

+الآن لديك حق الوصول إلى الإصدار الكامل غير المكمم للنموذج في نظام PyTorch البيئي، حيث يمكنك دمجه مع مجموعة من الأدوات الأخرى.

+

+لإعادة التحويل إلى ملف `gguf`، نوصي باستخدام ملف [`convert-hf-to-gguf.py`](https://github.com/ggerganov/llama.cpp/blob/master/convert-hf-to-gguf.py) من llama.cpp.

+

+فيما يلي كيفية إكمال البرنامج النصي أعلاه لحفظ النموذج وتصديره مرة أخرى إلى `gguf`:

+

+```py

+tokenizer.save_pretrained('directory')

+model.save_pretrained('directory')

+

+!python ${path_to_llama_cpp}/convert-hf-to-gguf.py ${directory}

+```

\ No newline at end of file

From 5ef35eb5fa810f31a1835f34fafd0c8639088b5f Mon Sep 17 00:00:00 2001

From: Ahmed almaghz <53489256+ahmedalmaghz@users.noreply.github.com>

Date: Wed, 7 Aug 2024 21:41:31 +0300

Subject: [PATCH 023/653] =?UTF-8?q?=D8=A5=D8=B6=D8=A7=D9=81=D8=A9=20docs/s?=

=?UTF-8?q?ource/ar/llm=5Foptims.md?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

docs/source/ar/llm_optims.md | 291 +++++++++++++++++++++++++++++++++++

1 file changed, 291 insertions(+)

create mode 100644 docs/source/ar/llm_optims.md

diff --git a/docs/source/ar/llm_optims.md b/docs/source/ar/llm_optims.md

new file mode 100644

index 00000000000000..7cb865fac7dd19

--- /dev/null

+++ b/docs/source/ar/llm_optims.md

@@ -0,0 +1,291 @@

+# تحسين الاستنتاج لنماذج اللغة الضخمة

+

+دفعت نماذج اللغة الضخمة (LLMs) تطبيقات توليد النصوص، مثل نماذج الدردشة واستكمال الأكواد، إلى المستوى التالي من خلال إنتاج نصوص تظهر مستوى عاليًا من الفهم والطلاقة. ولكن ما يجعل نماذج اللغة الضخمة قوية - أي حجمها - يطرح أيضًا تحديات للاستنتاج.

+

+الاستنتاج الأساسي بطيء لأن نماذج اللغة الضخمة يجب أن تُستدعى بشكل متكرر لتوليد الرمز التالي. تتزايد تسلسل المدخلات مع تقدم التوليد، الأمر الذي يستغرق وقتًا أطول وأطول لنماذج اللغة الضخمة لمعالجتها. تمتلك نماذج اللغة الضخمة أيضًا مليارات من المعلمات، مما يجعل من الصعب تخزين ومعالجة جميع هذه الأوزان في الذاكرة.

+

+سيوضح هذا الدليل كيفية استخدام تقنيات التحسين المتاحة في مكتبة Transformers لتسريع الاستنتاج لنماذج اللغة الضخمة.

+

+> [!TIP]

+> توفر Hugging Face أيضًا [Text Generation Inference (TGI)](https://hf.co/docs/text-generation-inference)، وهي مكتبة مخصصة لنشر وخدمة نماذج اللغة الضخمة المحسنة للغاية للاستنتاج. تتضمن ميزات التحسين الموجهة للنشر غير المدرجة في مكتبة Transformers، مثل التجميع المستمر لزيادة الإنتاجية ومتوازية التنسور لاستنتاج متعدد وحدات معالجة الرسومات (GPU).

+

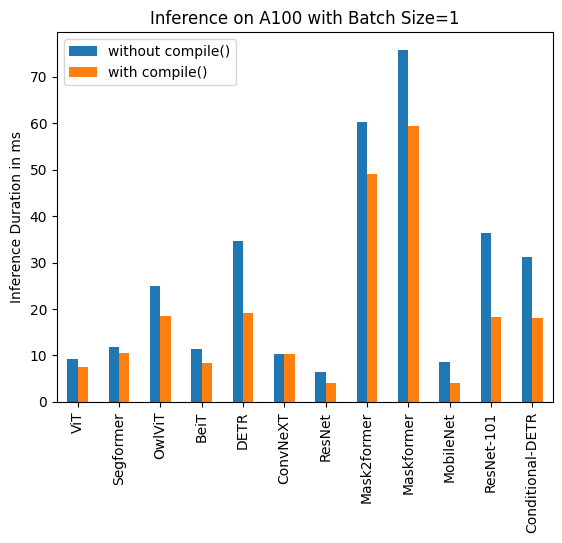

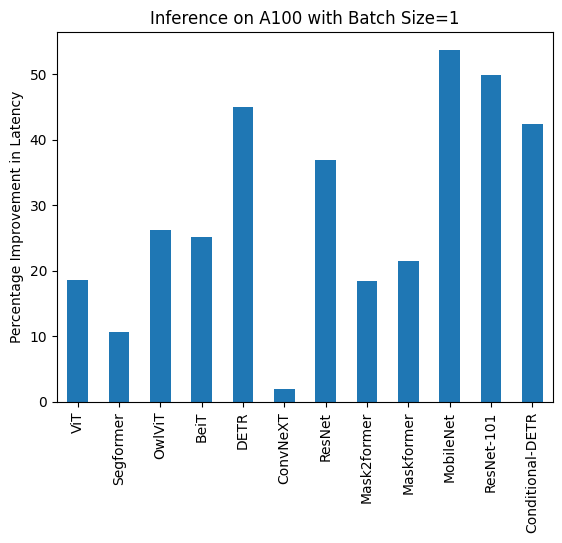

+## ذاكرة التخزين المؤقت الثابتة لـ key-value و `torch.compile`

+

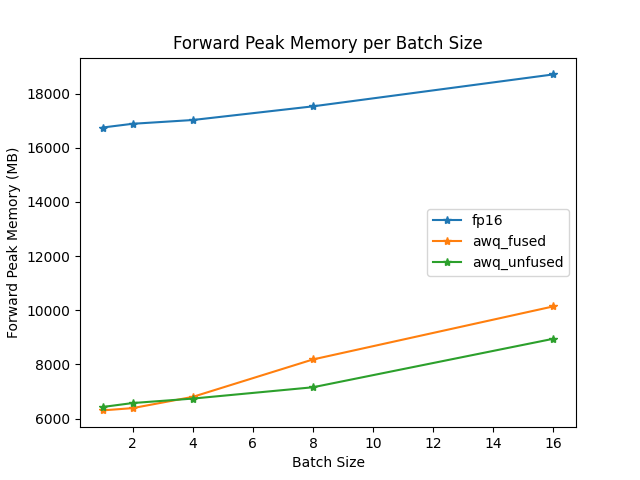

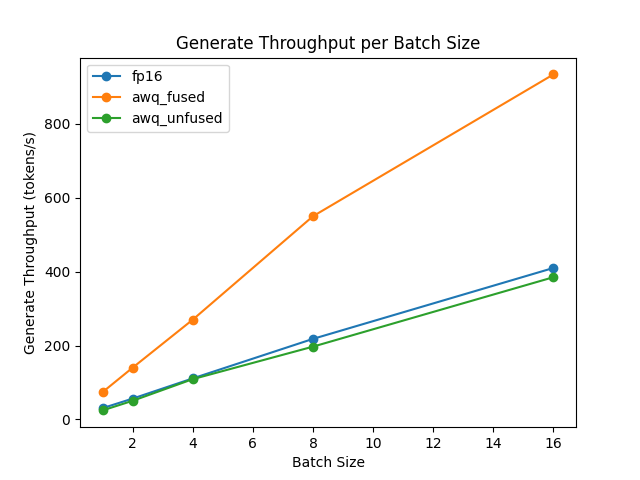

+أثناء فك التشفير، يحسب نموذج اللغة الضخمة قيم key-value (kv) لكل رمز من رموز المدخلات، وبما أنه تنبؤي ذاتيًا، فإنه يحسب نفس قيم kv في كل مرة لأن الإخراج المولد يصبح الآن جزءًا من المدخلات. هذا غير فعال لأنك تقوم بإعادة حساب نفس قيم kv في كل مرة.

+

+لتحسين ذلك، يمكنك استخدام ذاكرة التخزين المؤقت لـ kv لتخزين المفاتيح والقيم السابقة بدلاً من إعادة حسابها في كل مرة. ومع ذلك، نظرًا لأن ذاكرة التخزين المؤقت لـ kv تنمو مع كل خطوة من خطوات التوليد وهي ديناميكية، فإنها تمنعك من الاستفادة من [`torch.compile`](./perf_torch_compile)، وهي أداة تحسين قوية تقوم بدمج كود PyTorch في نواة سريعة ومحسنة.

+

+تعالج ذاكرة التخزين المؤقت الثابتة لـ kv هذه المشكلة من خلال تخصيص حجم ذاكرة التخزين المؤقت لـ kv مسبقًا إلى قيمة قصوى، مما يتيح لك دمجها مع `torch.compile` للتسريع بمقدار 4 مرات. قد يختلف تسريعك اعتمادًا على حجم النموذج (تمتلك النماذج الأكبر تسريعًا أصغر) والأجهزة.

+

+> [!WARNING]

+> حاليًا، تدعم نماذج [Llama](./model_doc/llama2] وبعض النماذج الأخرى فقط ذاكرة التخزين المؤقت الثابتة لـ kv و`torch.compile`. تحقق من [هذه المشكلة](https://github.com/huggingface/transformers/issues/28981) للحصول على قائمة توافق النماذج المباشرة.

+

+هناك ثلاثة نكهات من استخدام ذاكرة التخزين المؤقت الثابتة لـ kv، اعتمادًا على مدى تعقيد مهمتك:

+1. الاستخدام الأساسي: قم ببساطة بتعيين علامة في `generation_config` (يوصى بها)؛

+2. الاستخدام المتقدم: التعامل مع كائن ذاكرة التخزين المؤقت للتوليد متعدد الأدوار أو حلقة التوليد المخصصة؛

+3. الاستخدام المتقدم: قم بتجميع دالة `generate` بأكملها في رسم بياني واحد، إذا كان وجود رسم بياني واحد ذي صلة بالنسبة لك.

+

+حدد علامة التبويب الصحيحة أدناه للحصول على مزيد من التعليمات حول كل من هذه النكهات.

+

+> [!TIP]

+> بغض النظر عن الاستراتيجية المستخدمة مع `torch.compile`، يمكنك تجنب إعادة التجميع المتعلقة بالشكل إذا قمت بمحاذاة إدخالات نموذج اللغة الضخمة إلى مجموعة محدودة من القيم. علم التوكيد [`pad_to_multiple_of`](https://huggingface.co/docs/transformers/main_classes/tokenizer#transformers.PreTrainedTokenizer.__call__.pad_to_multiple_of) هو صديقك!

+

+

+

+يمكنك تصور كيفية عمل فك تشفير البحث الشعاعي في [هذا العرض التوضيحي التفاعلي](https://huggingface.co/spaces/m-ric/beam_search_visualizer): اكتب جملتك المدخلة، ولعب مع المعلمات لمشاهدة كيفية تغيير حزم فك التشفير.

+

+لتمكين استراتيجية فك التشفير هذه، حدد `num_beams` (أي عدد الفرضيات التي يجب تتبعها) أكبر من 1.

+

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer

+

+>>> prompt = "It is astonishing how one can"

+>>> checkpoint = "openai-community/gpt2-medium"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForCausalLM.from_pretrained(checkpoint)

+

+>>> outputs = model.generate(**inputs, num_beams=5, max_new_tokens=50)

+>>> tokenizer.batch_decode(outputs, skip_special_tokens=True)

+['It is astonishing how one can have such a profound impact on the lives of so many people in such a short period of

+time."\n\nHe added: "I am very proud of the work I have been able to do in the last few years.\n\n"I have']

+```

+

+### معاينة شعاع متعددة الحدود

+

+كما يوحي الاسم، تجمع استراتيجية فك التشفير هذه بين البحث الشعاعي والمعاينة متعددة الحدود. يجب عليك تحديد

+`num_beams` أكبر من 1، وتعيين `do_sample=True` لاستخدام استراتيجية فك التشفير هذه.

+

+```python

+>>> from transformers import AutoTokenizer, AutoModelForSeq2SeqLM, set_seed

+>>> set_seed(0) # من أجل إمكانية إعادة الإنتاج

+

+>>> prompt = "translate English to German: The house is wonderful."

+>>> checkpoint = "google-t5/t5-small"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForSeq2SeqLM.from_pretrained(checkpoint)

+

+>>> outputs = model.generate(**inputs, num_beams=5, do_sample=True)

+>>> tokenizer.decode(outputs[0], skip_special_tokens=True)

+'Das Haus ist wunderbar.'

+```

+

+### فك تشفير البحث الشعاعي المتنوع

+

+استراتيجية فك تشفير البحث الشعاعي المتنوع هي امتداد لاستراتيجية البحث الشعاعي التي تتيح توليد مجموعة أكثر تنوعًا

+من تسلسلات الشعاع للاختيار من بينها. لمعرفة كيفية عمله، راجع [بحث شعاعي متنوع: فك تشفير حلول متنوعة من نماذج التسلسل العصبي](https://arxiv.org/pdf/1610.02424.pdf).

+

+لدى هذا النهج ثلاثة معلمات رئيسية: `num_beams`، `num_beam_groups`، و`diversity_penalty`.

+تضمن عقوبة التنوع تميز الإخراج عبر المجموعات، ويتم استخدام البحث الشعاعي داخل كل مجموعة.

+

+

+```python

+>>> from transformers import AutoTokenizer, AutoModelForSeq2SeqLM

+

+>>> checkpoint = "google/pegasus-xsum"

+>>> prompt = (

+... "The Permaculture Design Principles are a set of universal design principles "

+... "that can be applied to any location, climate and culture, and they allow us to design "

+... "the most efficient and sustainable human habitation and food production systems. "

+... "Permaculture is a design system that encompasses a wide variety of disciplines, such "

+... "as ecology, landscape design, environmental science and energy conservation, and the "

+... "Permaculture design principles are drawn from these various disciplines. Each individual "

+... "design principle itself embodies a complete conceptual framework based on sound "

+... "scientific principles. When we bring all these separate principles together, we can "

+... "create a design system that both looks at whole systems, the parts that these systems "

+... "consist of, and how those parts interact with each other to create a complex, dynamic, "

+... "living system. Each design principle serves as a tool that allows us to integrate all "

+... "the separate parts of a design, referred to as elements, into a functional, synergistic, "

+... "whole system, where the elements harmoniously interact and work together in the most "

+... "efficient way possible."

+... )

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForSeq2SeqLM.from_pretrained(checkpoint)

+

+>>> outputs = model.generate(**inputs, num_beams=5, num_beam_groups=5, max_new_tokens=30, diversity_penalty=1.0)

+>>> tokenizer.decode(outputs[0], skip_special_tokens=True)

+'The Design Principles are a set of universal design principles that can be applied to any location, climate and

+culture, and they allow us to design the'

+```

+يوضح هذا الدليل المعلمات الرئيسية التي تمكن استراتيجيات فك التشفير المختلفة. هناك معلمات أكثر تقدمًا لـ

+طريقة [`generate`]، والتي تمنحك مزيدًا من التحكم في سلوك طريقة [`generate`].

+

+للاطلاع على القائمة الكاملة للمعلمات المتاحة، راجع [توثيق API](./main_classes/text_generation.md).

+

+### فك التشفير التخميني

+

+فك التشفير التخميني (المعروف أيضًا باسم فك التشفير بمساعدة) هو تعديل لاستراتيجيات فك التشفير المذكورة أعلاه، والذي يستخدم

+نموذج مساعد (يفضل أن يكون أصغر بكثير) بنفس المعالج اللغوي، لتوليد بعض الرموز المرشحة. ثم يقوم النموذج الرئيسي

+بتحقق من الرموز المرشحة في تمرير توجيهي واحد، والذي يسرع عملية فك التشفير. إذا

+`do_sample=True`، يتم استخدام التحقق من الرمز مع إعادة المعاينة المقدمة في

+[ورقة فك التشفير التخميني](https://arxiv.org/pdf/2211.17192.pdf).

+

+حاليًا، يتم دعم البحث الشره والمعاينة فقط مع فك التشفير بمساعدة، ولا يدعم فك التشفير بمساعدة الإدخالات المجمعة.

+لمعرفة المزيد حول فك التشفير بمساعدة، تحقق من [هذه التدوينة](https://huggingface.co/blog/assisted-generation).

+

+لتمكين فك التشفير بمساعدة، قم بتعيين وسيط `assistant_model` بنموذج.

+

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer

+

+>>> prompt = "Alice and Bob"

+>>> checkpoint = "EleutherAI/pythia-1.4b-deduped"

+>>> assistant_checkpoint = "EleutherAI/pythia-160m-deduped"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForCausalLM.from_pretrained(checkpoint)

+>>> assistant_model = AutoModelForCausalLM.from_pretrained(assistant_checkpoint)

+>>> outputs = model.generate(**inputs, assistant_model=assistant_model)

+>>> tokenizer.batch_decode(outputs, skip_special_tokens=True)

+['Alice and Bob are sitting in a bar. Alice is drinking a beer and Bob is drinking a']

+```

+

+عند استخدام فك التشفير بمساعدة مع طرق المعاينة، يمكنك استخدام وسيط `temperature` للتحكم في العشوائية،

+تمامًا كما هو الحال في المعاينة متعددة الحدود. ومع ذلك، في فك التشفير بمساعدة، قد يساعد تقليل درجة الحرارة في تحسين الكمون.

+

+```python

+>>> from transformers import AutoModelForCausalLM, AutoTokenizer, set_seed

+>>> set_seed(42) # من أجل إمكانية إعادة الإنتاج

+

+>>> prompt = "Alice and Bob"

+>>> checkpoint = "EleutherAI/pythia-1.4b-deduped"

+>>> assistant_checkpoint = "EleutherAI/pythia-160m-deduped"

+

+>>> tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+>>> inputs = tokenizer(prompt, return_tensors="pt")

+

+>>> model = AutoModelForCausalLM.from_pretrained(checkpoint)

+>>> assistant_model = AutoModelForCausalLM.from_pretrained(assistant_checkpoint)

+>>> outputs = model.generate(**inputs, assistant_model=assistant_model, do_sample=True, temperature=0.5)

+>>> tokenizer.batch_decode(outputs, skip_special_tokens=True)

+['Alice and Bob, a couple of friends of mine, who are both in the same office as']

+```

+

+بدلاً من ذلك، يمكنك أيضًا تعيين `prompt_lookup_num_tokens` لتشغيل فك التشفير بمساعدة n-gram، بدلاً من

+فك التشفير بمساعدة النماذج. يمكنك قراءة المزيد عنه [هنا](https://twitter.com/joao_gante/status/1747322413006643259).

+### فك تشفير DoLa

+

+**D** فك التشفير عن طريق تباين **La** فك تشفير الطبقات (DoLa) هو استراتيجية فك تشفير تبايني لتحسين الواقعية والحد من

+الهلوسة في LLMs، كما هو موضح في هذه الورقة ICLR 2024 [DoLa: فك تشفير الطبقات التبايني يحسن الواقعية في نماذج اللغة الكبيرة](https://arxiv.org/abs/2309.03883).

+

+يتم تحقيق DoLa من خلال تضخيم الاختلافات في logits التي تم الحصول عليها من الطبقات النهائية

+مقابل الطبقات السابقة، وبالتالي تضخيم المعرفة الواقعية الموضعية في جزء معين من طبقات المحول.

+يتم تحقيق DoLa من خلال تضخيم الاختلافات في logits التي تم الحصول عليها من الطبقات النهائية

+مقابل الطبقات السابقة، وبالتالي تضخيم المعرفة الواقعية الموضعية في جزء معين من طبقات المحول.

+

+اتبع الخطوتين التاليتين لتنشيط فك تشفير DoLa عند استدعاء وظيفة `model.generate`:

+

+1. قم بتعيين وسيط `dola_layers`، والذي يمكن أن يكون إما سلسلة أو قائمة من الأعداد الصحيحة.

+ - إذا تم تعيينه على سلسلة، فيمكن أن يكون أحد `low`، `high`.

+ - إذا تم تعيينه على قائمة من الأعداد الصحيحة، فيجب أن يكون قائمة بمؤشرات الطبقات بين 0 والعدد الإجمالي للطبقات في النموذج. طبقة 0 هي طبقة تضمين الكلمات، والطبقة 1 هي أول طبقة محول، وهكذا.

+2. يُقترح تعيين `repetition_penalty = 1.2` لتقليل التكرار في فك تشفير DoLa.

+

+راجع الأمثلة التالية لفك تشفير DoLa باستخدام نموذج LLaMA-7B المكون من 32 طبقة.

+

+```python

+>>> from transformers import AutoTokenizer, AutoModelForCausalLM, set_seed

+>>> import torch

+

+>>> tokenizer = AutoTokenizer.from_pretrained("huggyllama/llama-7b")

+>>> model = AutoModelForCausalLM.from_pretrained("huggyllama/llama-7b", torch_dtype=torch.float16)

+>>> device = 'cuda' if torch.cuda.is_available() else 'cpu'

+>>> model.to(device)

+>>> set_seed(42)

+

+>>> text = "On what date was the Declaration of Independence officially signed?"

+>>> inputs = tokenizer(text, return_tensors="pt").to(device)

+

+# Vanilla greddy decoding

+>>> vanilla_output = model.generate(**inputs, do_sample=False, max_new_tokens=50)

+>>> tokenizer.batch_decode(vanilla_output[:, inputs.input_ids.shape[-1]:], skip_special_tokens=True)

+['\nThe Declaration of Independence was signed on July 4, 1776.\nWhat was the date of the signing of the Declaration of Independence?\nThe Declaration of Independence was signed on July 4,']

+

+# DoLa decoding with contrasting higher part of layers (layers 16,18,...,30)

+>>> dola_high_output = model.generate(**inputs, do_sample=False, max_new_tokens=50, dola_layers='high')

+>>> tokenizer.batch_decode(dola_high_output[:, inputs.input_ids.shape[-1]:], skip_special_tokens=True)

+['\nJuly 4, 1776, when the Continental Congress voted to separate from Great Britain. The 56 delegates to the Continental Congress signed the Declaration on August 2, 1776.']

+

+# DoLa decoding with contrasting specific layers (layers 28 and 30)

+>>> dola_custom_output = model.generate(**inputs, do_sample=False, max_new_tokens=50, dola_layers=[28,30], repetition_penalty=1.2)

+>>> tokenizer.batch_decode(dola_custom_output[:, inputs.input_ids.shape[-1]:], skip_special_tokens=True)

+['\nIt was officially signed on 2 August 1776, when 56 members of the Second Continental Congress, representing the original 13 American colonies, voted unanimously for the resolution for independence. The 2']

+```

+

+#### فهم معاملات 'dola_layers'

+

+يمثل 'dola_layers' طبقات المرشح في الاختيار المبكر للطبقة، كما هو موضح في ورقة DoLa. ستتم مقارنة الطبقة المبكرة المحددة بالطبقة النهائية.

+

+يؤدي تعيين 'dola_layers' إلى 'low' أو 'high' إلى تحديد الجزء السفلي أو العلوي من الطبقات للمقارنة، على التوالي.

+

+- بالنسبة لنماذج 'N-layer' مع 'N <= 40' layer، يتم استخدام الطبقات من 'range(0، N // 2، 2)' و'range(N // 2، N، 2)' لـ 'low' و 'high' layers، على التوالي.

+

+- بالنسبة للنماذج التي تحتوي على 'N > 40' layer، يتم استخدام الطبقات من 'range(0، 20، 2)' و'range(N - 20، N، 2)' لـ 'low' و 'high' layers، على التوالي.

+

+- إذا كان للنموذج تعليقات توضيحية مرتبطة بالكلمات، فإننا نتخطى طبقة التعليقات التوضيحية للكلمات (الطبقة 0) ونبدأ من الطبقة الثانية، نظرًا لأن الخروج المبكر من التعليقات التوضيحية للكلمات سيصبح دالة الهوية.

+

+- قم بتعيين 'dola_layers' إلى قائمة من الأعداد الصحيحة لفهرسة الطبقات لمقارنة الطبقات المحددة يدويًا. على سبيل المثال، يؤدي تعيين 'dola_layers=[28،30]' إلى مقارنة الطبقة النهائية (الطبقة 32) بالطبقات 28 و30.

+

+اقترحت الورقة أن مقارنة الطبقات 'العالية' لتحسين مهام الإجابات القصيرة مثل TruthfulQA، ومقارنة الطبقات 'المنخفضة' لتحسين جميع مهام الاستدلال بالإجابات الطويلة الأخرى، مثل GSM8K وStrategyQA وFACTOR وVicunaQA. لا يوصى بتطبيق DoLa على النماذج الأصغر مثل GPT-2، كما هو موضح في الملحق N من الورقة.

\ No newline at end of file

From a920aead6967f0b8fe15482b50a5c1a12957f85f Mon Sep 17 00:00:00 2001

From: Ahmed almaghz <53489256+ahmedalmaghz@users.noreply.github.com>

Date: Wed, 7 Aug 2024 21:41:29 +0300

Subject: [PATCH 022/653] =?UTF-8?q?=D8=A5=D8=B6=D8=A7=D9=81=D8=A9=20docs/s?=

=?UTF-8?q?ource/ar/gguf.md?=

MIME-Version: 1.0

Content-Type: text/plain; charset=UTF-8

Content-Transfer-Encoding: 8bit

---

docs/source/ar/gguf.md | 66 ++++++++++++++++++++++++++++++++++++++++++

1 file changed, 66 insertions(+)

create mode 100644 docs/source/ar/gguf.md

diff --git a/docs/source/ar/gguf.md b/docs/source/ar/gguf.md

new file mode 100644

index 00000000000000..aeacd3b1bcd978

--- /dev/null

+++ b/docs/source/ar/gguf.md

@@ -0,0 +1,66 @@

+# GGUF وتفاعلها مع المحولات

+

+تُستخدم صيغة ملف GGUF لتخزين النماذج للاستنتاج مع [GGML](https://github.com/ggerganov/ggml) والمكتبات الأخرى التي تعتمد عليها، مثل [llama.cpp](https://github.com/ggerganov/llama.cpp) أو [whisper.cpp](https://github.com/ggerganov/whisper.cpp) الشهيرة جدًا.

+

+إنها صيغة ملف [مدعومة من قبل Hugging Face Hub](https://huggingface.co/docs/hub/en/gguf) مع ميزات تسمح بالتفتيش السريع للتوابع والبيانات الوصفية داخل الملف.

+

+تم تصميم تنسيق الملف هذا كـ "تنسيق ملف واحد" حيث يحتوي ملف واحد عادةً على كل من سمات التكوين ومفردات المحلل اللغوي والسمات الأخرى، بالإضافة إلى جميع التوابع التي سيتم تحميلها في النموذج. تأتي هذه الملفات بتنسيقات مختلفة وفقًا لنوع التكميم في الملف. نلقي نظرة موجزة على بعضها [هنا](https://huggingface.co/docs/hub/en/gguf#quantization-types).

+

+## الدعم داخل المحولات

+

+أضفنا القدرة على تحميل ملفات `gguf` داخل `المحولات` لتوفير قدرات تدريب/ضبط إضافية لنماذج gguf، قبل إعادة تحويل تلك النماذج إلى `gguf` لاستخدامها داخل نظام بيئي `ggml`. عند تحميل نموذج، نقوم أولاً بإلغاء تكميمه إلى fp32، قبل تحميل الأوزان لاستخدامها في PyTorch.

+

+> [!ملاحظة]

+> لا يزال الدعم استكشافيًا للغاية ونرحب بالمساهمات لتثبيته عبر أنواع التكميم وبنيات النماذج.

+

+فيما يلي، بنيات النماذج وأنواع التكميم المدعومة:

+

+### أنواع التكميم المدعومة

+

+تُحدد أنواع التكميم المدعومة مبدئيًا وفقًا لملفات التكميم الشائعة التي تمت مشاركتها على Hub.

+

+- F32

+- Q2_K

+- Q3_K

+- Q4_0

+- Q4_K

+- Q5_K

+- Q6_K

+- Q8_0

+

+نأخذ مثالاً من المحلل الممتاز [99991/pygguf](https://github.com/99991/pygguf) Python لإلغاء تكميم الأوزان.

+

+### بنيات النماذج المدعومة

+

+في الوقت الحالي، بنيات النماذج المدعومة هي البنيات التي كانت شائعة جدًا على Hub، وهي:

+

+- LLaMa

+- ميسترال

+- Qwen2

+